MCP Server 解决了哪些核心问题?AI Agent 为何需要它?

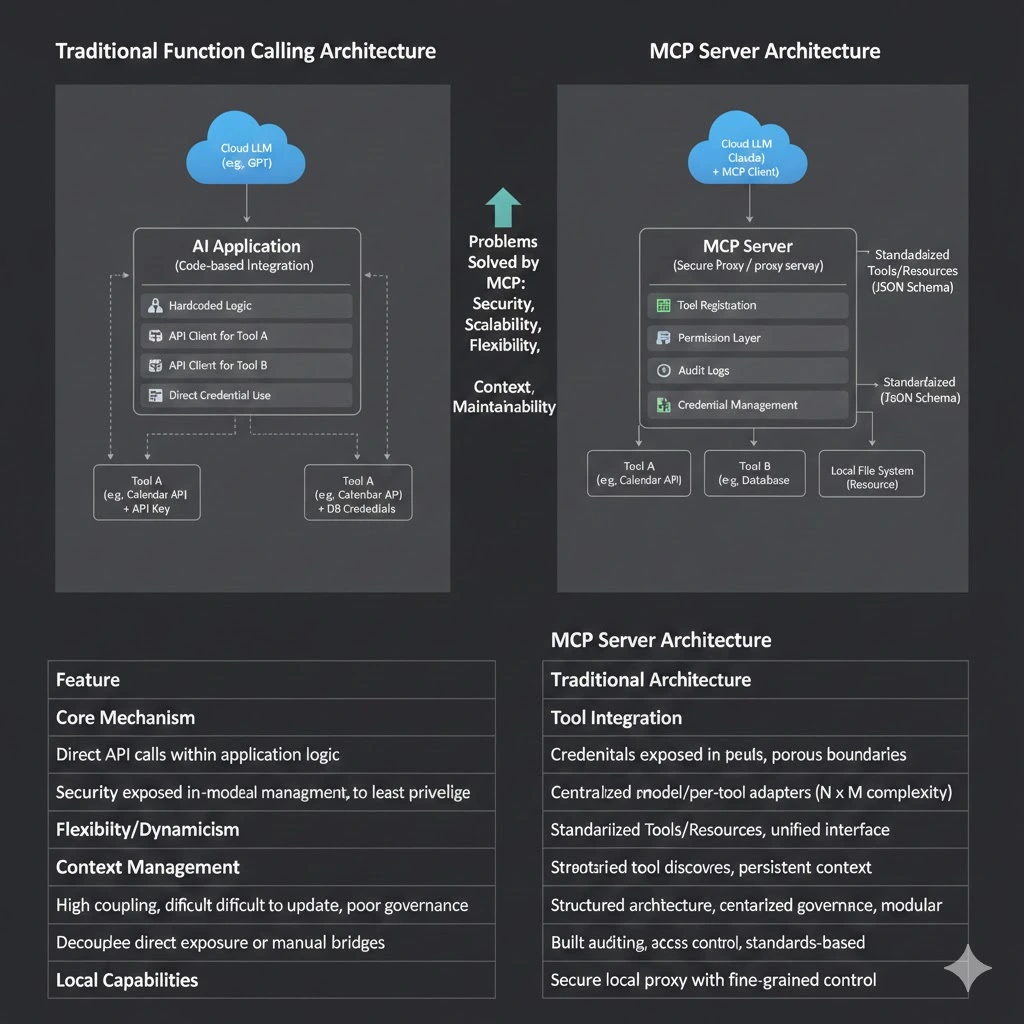

在早期 AI 应用中,通过"Function Calling"等方式调用 API 足以支撑简单的自动化需求。但当 AI 从「对话工具」演进为具备自主规划与执行能力的 Agent 时,我们开始遇到一系列系统性的工程挑战:工具难以统一、安全地接入,架构难以随模型迭代而灵活演进。

这些问题的根源,在于缺乏一层专为 AI 交互模式设计的标准化能力层。Model Context Protocol (MCP) 协议及其核心实现 MCP Server,正是在这一背景下应运而生,它定义了标准化的方式,将模型与外部数据源、工具和服务连接起来,从而支持可扩展的 AI Agent 系统。

本文为您解读MCP Server出现带来了哪些核心价值,解决了哪些关键问题。

适宜的阅读人群:

- 技术爱好者和入门级学习者

- 寻求效率提升的职场人士与管理者

- 企业决策者与业务部门负责人

- 对AI未来发展趋势感兴趣的普通用户

本文目录:

- 1. 当 LLM 需要“行动能力”:如何安全访问真实世界?

- 2. 当任务变得开放:为什么硬编码流程开始失效?

- 3. 当模型不断变化:如何避免工具与模型强耦合?

- 4. 当任务变长:为什么上下文开始碎片化?

- 5. 当能力在本地:如何安全地连接云模型?

- 6. 当 Agent 规模扩大:系统如何可维护?

- 7. 当 AI 进入企业:如何安全复用内部系统?

- MCP Server 不只是协议,而是AI Agent 时代的关键基础设施

1. 当 LLM 需要“行动能力”:如何安全访问真实世界?

问题背景

大语言模型(LLM)本质上是文本生成器,但本身不具备直接访问外部系统或执行动作的能力。要让 LLM 能连接外部世界,就必须为其提供访问 API、数据库或文件系统的通道,这立即带来了安全与适配的难题,如果没有统一的安全执行层,单独适配每个工具既繁琐又不安全。

没有 MCP Server 时

开发者需要为每个工具编写特定的集成代码,并将敏感凭证(如 API 密钥)或内部系统直接暴露给 AI 应用,安全边界模糊,风险极高。总结为:

- LLM 只能“生成文本”,无法触发实际动作

- 每个外部系统必须单独为每种模型写适配代码

- API Key 或内部凭据需要暴露给调用方,带来安全风险

MCP Server 的解决方案

MCP Server 的核心作用之一是作为安全代理。它运行在一个可信的环境中,负责持有和管理所有敏感凭证。根据 MCP 官方定义,Server 对外暴露的是标准化的 Tools ,这些工具通过清晰的 JSON Schema 描述其功能和所需参数。AI 应用(MCP客户端)通过调用 tools/list 获取到工具的描述,模型基于这些描述来决定何时调用工具,而具体的执行、包括权限校验和审计日志,完全由 MCP Server 控制。这种设计确保了 最小权限原则 得以实施。

MCP Server 是遵循 MCP 协议的服务端程序,它能够标准化地将外部能力封装成工具接口(Tools)或资源接口(Resources),并通过安全机制控制访问。

- 将各种真实能力(如数据库、API、文件系统)封装为标准化工具

- 模型只需理解工具的能力说明与参数结构

- 实际权限验证、执行和安全边界由 MCP Server 负责

LLM 得以安全地与真实世界交互,从“只能聊天”演进为可执行任务的 AI Agent,而无需承担直接暴露核心系统的安全风险。但需要注意的是MCP 协议定义了能力暴露与调用的标准方式,而安全控制与权限模型由具体 MCP Server 实现负责。

2. 当任务变得开放:为什么硬编码流程开始失效?

问题背景

AI Agent 的价值在于处理开放域、多步骤的复杂任务,其执行路径往往是动态和非确定性的。传统的 API 集成模式依赖于开发者预先编写好固定的调用逻辑,无法适应这种灵活性。

传统 API / Function Calling 的局限

每次任务流程变更或新增工具都需要修改和重新部署应用程序代码,系统僵化,难以适应快速变化的需求。主要提现为:

- 调用逻辑被写死在应用代码中

- 新增工具或改变流程需修改代码并重新部署

- 不适合开放式动态决策任务

MCP Server 的解决方案

MCP 协议支持动态工具发现。MCP Client(集成在 AI 应用端)在启动时可以自动发现连接的 Server 提供了哪些工具。这意味着工具集可以独立于 AI 应用进行更新和扩展。Agent 能够根据实时发现的能力,自主推理并规划调用哪些工具、以何种顺序来完成任务,实现了从 “人写死流程”到“模型动态规划流程” 的根本转变。

MCP协议定义了工具和资源的标准 Schema,使得它们可以“动态发现并调用”。

- 工具以规范化的 Schema 暴露其功能

- 调用决策和执行顺序由模型推理决定,而非硬编码

- MCP 为 Agent 的自主规划提供了必要的能力暴露与上下文基础

本质变化

系统的智能核心从固定的代码逻辑,转移到了模型基于对工具能力的理解所进行的实时推理上。从“人为定义流程”变成“模型根据语义规划流程”。

3. 当模型不断变化:如何避免工具与模型强耦合?

问题背景

AI 领域模型迭代迅速,同一个组织内可能同时使用来自 OpenAI、Anthropic、Google 或其他开源模型。如果工具集成代码与特定模型的 SDK 或调用方式深度绑定,那么切换或增加模型将带来巨大的重复开发和维护成本。

没有 MCP Server 时

每个模型都需要一套独立的工具适配层,形成 N 个模型 x M 个工具的 N x M 集成复杂度,维护成本指数级上升。

- 每个模型都有自己的一套工具定义

- 开发者需要分别为不同模型编写兼容适配逻辑

- 系统维护成本大幅上升

MCP Server 的解决方案

MCP 作为一个开放协议,充当了通用的中间语言。任何实现了 MCP Client 的 AI 应用(如 Claude Desktop、Cursor IDE 等)都能与任何遵循 MCP 协议的 Server 通信。工具开发者只需按标准实现一次 MCP Server,即可让其能力被多个不同后端的 AI 应用所使用。这彻底将工具与特定的 AI 模型解耦,工具只需按照 MCP 协议注册自己,一套 MCP Server 能被多个不同的 LLM 同时使用。

MCP Server的出现让开发者从为某个模型“编写适配器”的重复劳动中解放出来,转而建设一套可持续复用、模型无关的 AI 能力基础设施。

4. 当任务变长:为什么上下文开始碎片化?

问题背景

在复杂的多轮 Agent 任务中,信息分散在不同工具调用的返回结果、读取的文件内容以及对话历史中。传统方式下,将这些非结构化的信息有效地组织并持续提供给模型,是一个巨大挑战,容易导致模型“忘记”关键信息或做出矛盾决策。

常见问题

- 工具调用返回结果难以复用

- 多阶段任务中的状态不连贯

- 模型缺乏整体上下文认知

MCP Server 的解决方案

MCP协议定义了**资源(Resources)**这一核心原语。Resources是只读的、结构化的数据源(如文件、API文档、数据库表结构)。MCP Server可以暴露Resources,MCP Client则可以按需读取(resources/read)并将其内容作为上下文提供给模型。这为Agent提供了持续、结构化的外部知识,有效缓解了上下文碎片化问题。

MCP Server让Agent 在多步骤任务中可以拥有持续、结构化的上下文,而不是“临时记住信息”。

5. 当能力在本地:如何安全地连接云模型?

许多企业核心能力(如访问本地文件系统、Git 仓库、内部开发工具链)驻留在用户本地或企业内网,而用户可能希望使用强大的云端 LLM 来驱动这些能力。直接向云端模型开放本地权限是极不安全的。

没有 MCP Server时

- 文件系统、版本控制系统等无法安全访问

- 必须赋予过高权限才能实现调用

- 容易导致凭证泄露或被滥用

MCP Server 的解决方案

MCP Server 可以作为一个轻量级进程运行在本地环境中,并只暴露经过授权的能力,因此模型可以安全访问所需资源,而不会越权。。例如,在 Claude Desktop 中,用户可以配置本地文件系统、Git 等 MCP Server。这些 Server 仅向云端 Claude 暴露严格限定的、无害化的操作(如读取特定目录的文件、获取 git log)。所有请求都通过安全的本地通道进行,云端模型发出的指令由本地 Server 校验并执行,能力暴露的范围被精确控制。这正是在 IDE 智能编程助手场景中,MCP 架构能兼顾强大功能与安全性的核心原因。

此设计正是 MCP 在 IDE 和本地开发场景中快速普及的核心原因。

6. 当 Agent 规模扩大:系统如何可维护?

在大型系统中,一个 Agent 可能需要访问多个工具,权限策略复杂、调用逻辑分散,使得维护变得困难。

传统架构的痛点

- 工具散落各处,无统一治理

- Agent 逻辑复杂难以维护

- 权限和审计分布式

MCP Server 的解决方案

MCP 为工具和数据访问提供集中管理层:

- 工具集中注册和管理

- Agent 只关心其可用能力

- MCP Server 成为 Agent 的“能力抽象层”

这种分层治理非常适合企业级系统架构升级。

7. 当 AI 进入企业:如何安全复用内部系统?

企业希望利用 AI 提升运营效率,但内部系统(如 CRM、ERP、数据库)通常接口不标准、权限模型复杂,且面临严格的合规与审计要求。因此,直接将这些系统暴露给模型是不安全的。

MCP Server 的解决方案

在企业架构中,MCP Server 可以扮演 AI 专用的“能力网关” 角色。每个关键内部系统(如 Salesforce、Jira、内部数据库)都可以由一个专用的 MCP Server 进行封装。这个 Server 负责:

适配与抽象:将内部复杂的 API 转化为标准化的 MCP Tools,隐藏内部 API 的复杂性。

权限集中:集成企业身份认证(如 SSO),并在工具级别实施访问控制。

审计日志:集中记录所有 AI 发起操作的详细日志,满足合规要求。

通过这种方式,在企业架构中,MCP Server 可以被视为 AI 能力层的‘防火墙与适配器’,为不同 Agent 和模型提供一致、安全的接入方式,使得 AI 在安全、可控的前提下赋能业务。

MCP Server 不只是协议,而是AI Agent 时代的关键基础设施

综上所述,MCP Server 解决的并非单一技术点,而是 AI Agent 在迈向规模化、工程化应用过程中所面临的一系列结构性挑战:

- 安全挑战:通过代理模式实现最小权限访问。

- 集成挑战:通过标准化协议解耦工具与模型,降低

N x M的集成复杂度。 - 灵活性挑战:通过动态发现支持 Agent 自主规划,适应开放域任务。

- 上下文挑战:通过 Resources 等原语提供结构化外部记忆。

- 企业化挑战:通过网关模式满足权限、审计与合规要求。

MCP(Model Context Protocol) 不仅定义了模型与外部系统通信的标准化方式,同时也为构建可扩展、安全的 AI Agent 平台提供了基础设施。

它解决了从“能力暴露”“工具治理”“模型解耦”“上下文管理”到“安全访问”的一整类系统性问题,使得 多模型、多工具、复杂任务场景下的 AI Agent 开发变得可持续、可维护且安全。

正如 Anthropic 在宣布将 MCP 捐赠给 Linux 基金会以成立 Agentic AI Foundation 时所言,此举旨在推动 AI Agent 互操作性标准的开放发展。MCP Server 正是这一愿景下的关键构件,它为实现一个由不同 AI 和工具能安全、高效协作的智能未来,提供了坚实可靠的基础设施层。当 AI 从演示走向生产,从单点应用走向复杂系统,MCP Server 提供了一套经过深思熟虑的、可扩展的工程答案。

MCP系列文章:

- MCP Server 全面解析:AI Agent 时代的上下文与工具通信中枢

- MCP Server 解决了哪些关键问题?为什么 AI Agent 需要它

- MCP Server 架构与工作原理详解:从协议到执行流程

- MCP Server 实战指南:从 0 到 1 构建、测试与部署

- MCP Server 应用场景评估与技术选型指南

关于作者

本文内容由 NavGood 内容编辑团队 整理发布。

NavGood 是一个专注于 AI 工具与 AI 应用生态的导航与内容平台,长期跟踪 AI Agent、自动化工作流与生成式 AI 技术的发展与落地实践。

免责声明: 本文仅代表作者的个人理解和实践经验。它不代表任何框架、组织或公司的官方立场,也不构成商业、金融或投资建议。所有信息均基于公开来源和作者的独立研究。

参考资料:

[1]: https://modelcontextprotocol.io/docs/learn/server-concepts "Understanding MCP servers - Model Context Protocol"

[2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol"

[3]: https://cloud.google.com/blog/products/ai-machine-learning/announcing-official-mcp-support-for-google-services "Announcing Model Context Protocol (MCP) support for Google services"

[4]: https://developer.pingidentity.com/identity-for-ai/agents/idai-what-is-mcp.html "What is Model Context Protocol (MCP)?"