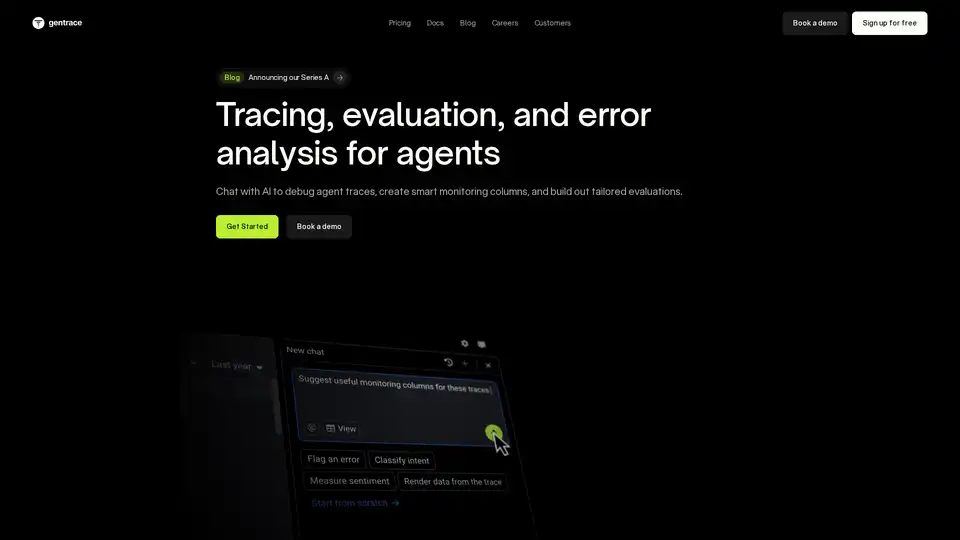

Gentrace 概述

什么是 Gentrace?

Gentrace 是一个平台,旨在帮助团队追踪、评估和分析其 AI 代理和大型语言模型 (LLM) 应用程序中的错误。它提供了用于调试代理追踪、自动化评估和构建定制评估的工具,以确保可靠的 AI 输出。

Gentrace 如何工作?

Gentrace 的工作原理是提供一个追踪 SDK,该 SDK 与常见的代理框架和 LLM 集成。此 SDK 允许开发人员追踪 AI 代理交互、捕获数据并将其发送到 Gentrace 平台进行分析。然后,该平台提供以下工具:

- 与追踪聊天: 一个由 AI 驱动的聊天界面,灵感来自 Cursor,允许用户询问有关其代理追踪的问题并识别问题。

- 生成自定义监控代码: AI 驱动的监控代码生成,针对特定用例量身定制,可在每次追踪时自动运行以发现问题。

- 设置通知: 针对关键 AI 问题和定期质量摘要的即时通知,以跟踪 AI 性能。

- 评估代理性能: 用于轻量级评估的工具,可提供即时见解,以及全面的测试工作流程。

Gentrace 的主要特性

- 错误分析: 使用 AI 驱动的聊天(具有代理追踪的完整上下文)识别和修复 AI 问题。

- 自定义监控: 生成针对特定用例量身定制的自定义监控代码,以自动发现 AI 输出中的问题。

- 易于安装: 最小化的追踪 SDK,用于快速追踪 AI 代理,并与常见的代理框架和 LLM 广泛兼容。

- 评估工具: 通过强大的评估工具和轻量级设置,在回归生效之前捕获它们。

- 灵活的数据集管理: 将测试数据存储在 Gentrace 或您的代码库中,并使用内置的管理工具高效地组织它们。

- 企业级安全性: 通过 SOC 2 Type II 和 ISO 27001 合规性实现企业级安全性,并提供云或自托管部署选项。

如何使用 Gentrace

- 生成 API 密钥: 单击以生成唯一的 API 密钥。

- 验证: 使用 npm 安装 Gentrace SDK。

- 在您的项目中初始化: 使用 TypeScript 或 Python 代码初始化 SDK 并定义 LLM 交互。

// Run a "unit test" evaluation

await evalOnce('rs-in-strawberry', async () => {

const response = await openai.chat.completions.create({

model: 'gpt-o4-mini',

messages: [{ role: 'user', content: 'How many rs in

strawberry? Return only the number.'}],

});

const output = response.choices[0].message.content;

if (output !== '3') {

throw new Error('Output is not 3: ${output}’ );

}

});

为什么选择 Gentrace?

Gentrace 为使用 AI 代理和 LLM 的团队提供了以下几个优势:

- 改进的调试: Gentrace Chat 帮助快速识别和修复代理追踪中的问题。

- 自动监控: 自定义监控代码生成可自动执行发现 AI 输出中问题的过程。

- 全面的评估: 强大的评估工具可帮助在回归生效之前捕获它们。

- 企业级安全性: 企业级安全功能可确保您的 AI 应用程序的安全性和合规性。

Gentrace 适合谁?

Gentrace 专为以下人员设计:

- AI 工程师: 需要调试和监控 AI 代理性能。

- 机器学习工程师: 正在构建和部署 LLM 应用程序。

- 数据科学家: 正在评估和改进 AI 模型。

- 团队: 正在构建和部署 AI 驱动的产品。

Gentrace 的实际价值

Gentrace 通过以下方式提供实际价值:

- 减少调试时间: 通过提供 AI 驱动的聊天和追踪工具,Gentrace 帮助开发人员快速识别和修复其 AI 代理中的问题。

- 提高 AI 质量: 通过自动化监控和评估,Gentrace 帮助确保 AI 代理按预期执行。

- 加速开发: 通过为 AI 代理开发提供全面的平台,Gentrace 帮助团队更快地构建和部署 AI 驱动的产品。

用户评价

Gentrace 是适合我们的产品,因为它允许我们实施自己的自定义评估,这对我们独特的用例至关重要。它极大地提高了我们预测 LLM 实现中即使是很小的更改的影响的能力。

Madeline Gilbert Quizlet 的 Staff Machine Learning Engineer

结论

Gentrace 是一个全面的平台,用于追踪、评估和分析 AI 代理和 LLM 应用程序中的错误。凭借其强大的调试工具、自动监控和企业级安全功能,Gentrace 是构建和部署 AI 驱动的产品的团队的宝贵工具。无论您是 AI 工程师、机器学习工程师还是数据科学家,Gentrace 都可以帮助您构建更可靠和有效的 AI 应用程序。

"Gentrace"的最佳替代工具

Lunary 是一个开源 LLM 工程平台,提供可观测性、提示管理和分析功能,用于构建可靠的 AI 应用程序。它提供调试、跟踪性能和确保数据安全的工具。

Vivgrid 是一个 AI 代理基础设施平台,帮助开发者构建、观察、评估和部署具有安全防护和低延迟推理的 AI 代理。它支持 GPT-5、Gemini 2.5 Pro 和 DeepSeek-V3。

Parea AI 是一个 AI 实验和标注平台,可帮助团队自信地发布 LLM 应用程序。 它提供实验跟踪、可观测性、人工审查和提示部署等功能。

UpTrain 是一个全栈 LLMOps 平台,提供企业级工具,用于评估、实验、监控和测试 LLM 应用程序。在您自己的安全云环境中托管,并自信地扩展 AI。

Pydantic AI 是一个 Python 中的 GenAI 代理框架,旨在构建生产级生成式 AI 应用程序。它支持各种模型,提供无缝的可观察性,并确保类型安全开发。

FinetuneDB 是一个 AI 微调平台,让您快速创建和管理数据集,以低成本训练自定义 LLM,通过生产数据和协作工具提升模型性能。

Dynamiq 是一个本地平台,用于构建、部署和监控 GenAI 应用。通过 LLM 微调、RAG 集成和可观测性等功能,简化 AI 开发,降低成本并提升业务 ROI。

Arize AI 为 AI 应用程序提供统一的 LLM 可观测性和代理评估平台,涵盖从开发到生产的全过程。实时优化提示、跟踪代理并监控 AI 性能。

Keywords AI 是领先的 LLM 监控平台,专为 AI 初创公司设计。只需 2 行代码即可轻松监控和改进您的 LLM 应用程序。调试,测试 prompts,可视化日志并优化性能,从而提升用户满意度。

PromptLayer 是一个 AI 工程平台,用于提示管理、评估和 LLM 可观察性。与专家协作,监控 AI 代理,并使用强大的工具提高提示质量。