Runpod 概述

Runpod: 一体化 AI 云平台

什么是 Runpod?

Runpod 是一个综合性的云平台,旨在简化构建、训练和部署 AI 模型的过程。它解决了 AI 工程师面临的常见挑战,例如基础设施管理、扩展和冷启动。通过提供一个功能齐全、支持 GPU 的环境,该环境可以在不到一分钟的时间内启动,Runpod 旨在使 AI 开发更易于访问和高效。

主要特性:

- 轻松部署: 简化了将 AI 模型投入生产的过程。

- 全球覆盖: 允许用户在全球多个区域运行工作负载。

- 自动伸缩: 动态适应工作负载需求,实时从 0 扩展到 100+ 个计算工作节点。

- 零冷启动: 通过始终在线的 GPU 确保不间断的执行。

- FlashBoot: 通过低于 200 毫秒的冷启动实现闪电般的快速扩展。

- 持久数据存储: 提供与 S3 兼容的存储,用于完整的 AI 管道,无需出口费用。

Runpod 如何工作?

Runpod 提供了一个平台,您可以在其中快速部署和扩展您的 AI 工作负载。 它提供了几个关键特性,使之成为可能:

- 支持 GPU 的环境: Runpod 提供对支持 GPU 的环境的访问,这对于训练和运行 AI 模型至关重要。

- 自动伸缩: 该平台可以根据需求自动伸缩资源,确保您在需要时拥有所需的计算能力。

- 低延迟: 借助 FlashBoot 和全球部署选项等功能,Runpod 有助于降低延迟并提高性能。

- 持久存储: 该平台提供持久数据存储,使您可以在不产生出口费用的情况下管理您的数据。

用例:

Runpod 适用于广泛的 AI 应用,包括:

- 推理: 为图像、文本和音频生成提供推理服务。

- 微调: 在特定数据集上训练自定义模型。

- 代理: 构建基于智能代理的系统和工作流程。

- 计算密集型任务: 运行渲染和模拟。

优势:

- 经济高效: 只为您使用的内容付费,按毫秒计费。

- 可扩展: 通过 GPU 工作节点即时响应需求,这些节点可以在几秒钟内从 0 扩展到 1000+。

- 可靠: 保证关键工作负载 99.9% 的正常运行时间。

- 安全: 致力于安全性,目前正在进行 SOC2、HIPAA 和 GDPR 认证。

如何开始使用 Runpod?

- 注册: 在 Runpod 平台上创建一个帐户。

- 探索模板: 使用预构建的模板来启动您的 AI 工作流程。

- 自定义: 配置 GPU 模型、扩展行为和其他设置以适应您的特定需求。

- 部署: Runpod 简化了部署和扩展 AI 模型的过程,使您可以专注于创新而不是基础设施管理。

为什么 Runpod 很重要?

Runpod 通过提供一个可扩展、经济高效且易于使用的平台来解决部署 AI 模型所面临的挑战。它允许 AI 工程师专注于构建和创新,而不会被基础设施管理所困扰。凭借自动伸缩、零冷启动和持久数据存储等功能,Runpod 对于任何使用 AI 的人来说都是一个有价值的工具。

客户评价:

多家公司称赞 Runpod 能够扩展 GPU 基础设施并降低基础设施成本。例如,InstaHeadshots 的联合创始人 Bharat 表示,Runpod 使他们能够完全专注于增长和产品开发,而不必担心 GPU 基础设施。

结论:

Runpod 是一个功能强大且多功能的云平台,适用于 AI 开发和部署。它专注于简单性、可扩展性和成本效益,使其成为希望利用 AI 力量的企业和个人的有吸引力的选择。通过抽象化基础设施管理的复杂性,Runpod 使人们能够构建未来,而不会受到基础设施限制的阻碍。

"Runpod"的最佳替代工具

Deployo 简化了 AI 模型部署,可在几分钟内将模型转化为可用于生产的应用程序。与云无关、安全且可扩展的 AI 基础设施,可实现轻松的机器学习工作流程。

Xander是一个开源桌面平台,支持无代码AI模型训练。只需用自然语言描述任务,即可自动化文本分类、图像分析和LLM微调流程,在本地机器上确保隐私和性能。

Falcon LLM 是 TII 的开源生成式大语言模型家族,包括 Falcon 3、Falcon-H1 和 Falcon Arabic 等,支持多语言、多模态 AI 应用,可在日常设备上高效运行。

Lumino 是一个易于使用的 SDK,用于在全球云平台上进行 AI 训练。 降低高达 80% 的 ML 训练成本,并访问其他地方无法使用的 GPU。 立即开始训练您的 AI 模型!

GreenNode提供全面的AI就绪基础设施和云解决方案,配备H100 GPU,起价为每小时2.34美元。 访问预配置的实例和完整的AI平台,开启您的AI之旅。

Lightning AI是一个一体化云工作空间,旨在构建、部署和训练AI代理、数据和AI应用程序。只需一个订阅即可获得模型API、GPU训练和多云部署。

Denvr Dataworks 提供高性能 AI 计算服务,包括按需 GPU 云、AI 推理和私有 AI 平台。 使用 NVIDIA H100、A100 和 Intel Gaudi HPU 加速您的 AI 开发。

使用Floor Plan AI免费使用AI设计和生成平面图。只需点击几下,即可将文本或草图转换为布局和可用于3D的视觉效果。无需注册。

AI Runner是一个离线AI推理引擎,用于艺术创作、实时语音对话、LLM驱动的聊天机器人和自动化工作流程。在本地运行图像生成、语音聊天等!

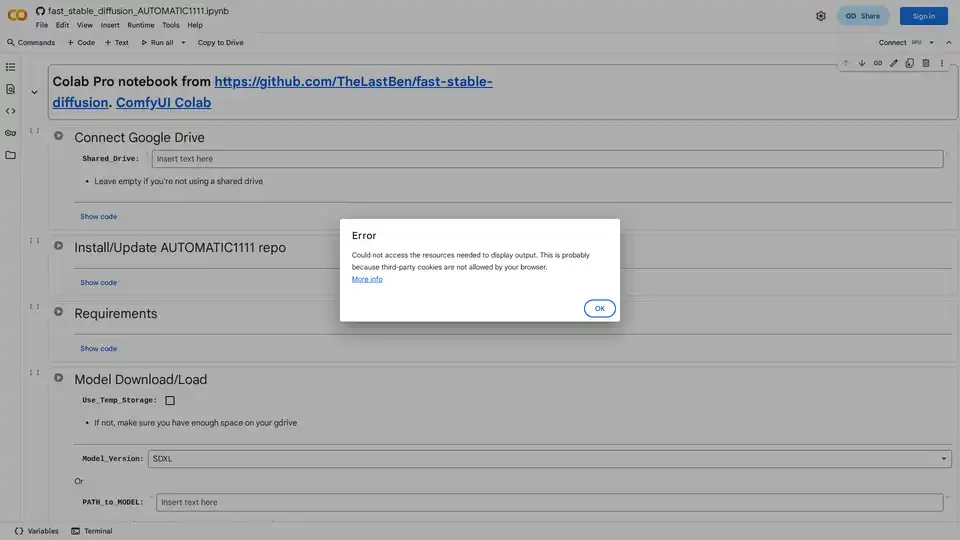

了解如何在 Google Colab 上使用 AUTOMATIC1111 的 Web UI 轻松运行 Stable Diffusion。安装模型、LoRA 和 ControlNet,实现快速 AI 图像生成,无需本地硬件。