Lumino 概述

Lumino:用于AI训练的全球云平台

什么是 Lumino?Lumino 是一个全球云平台和一个易于使用的 SDK,旨在简化和加速机器学习 (ML) 模型的开发和训练。它的目标是显著降低 ML 训练成本,同时提供对原本难以获得的 GPU 的访问。

主要特性和优势

- 易于使用的 SDK: Lumino 提供了一个简单的 SDK,允许用户使用预配置的模板构建模型或导入其自定义模型。可以在几秒钟内完成部署。

- 永不耗尽的计算资源: 该平台提供即时自动缩放,以消除空闲时间,确保在需要时始终可以使用计算资源。

- 极其便宜: Lumino 采用按训练作业付费的定价模式,这意味着用户只需为实际使用的计算资源付费。这有助于避免与未使用的资源相关的不必要成本。

- 保持数据私密性: 用户保留对其数据的完全控制权,确保隐私并符合数据法规。

- 透明且可审计: 所有模型都可以通过加密验证的证明进行追溯,从而促进完全的问责制和透明度。

Lumino 如何工作?

Lumino 提供了对针对 AI 和机器学习工作负载优化的全球云基础设施的访问。它通过提供预配置的环境和工具来简化模型训练过程。它的架构允许高效的资源分配和利用,从而降低成本。

如何使用 Lumino?

- 注册 Lumino 帐户

- 访问 Lumino SDK

- 构建或导入您的模型

- 配置训练参数

- 部署和训练

Lumino 适合哪些人?

Lumino 迎合了广泛的用户:

- AI/ML 开发人员: 那些需要经济高效且易于使用的平台来训练其模型的人员。

- 初创公司和小型企业: 预算有限但希望利用 AI 而无需大量基础设施投资的公司。

- 研究人员: 需要访问高性能计算资源以进行研究项目的个人和团队。

- 企业: 旨在优化其 AI 开发工作流程并降低训练成本的大型组织。

客户评价

一些用户分享了他们对 Lumino 的积极体验:

- 来自 EQTY Lab 的 Andrew Stanco 称赞 Lumino 在关键短缺期间提供了对 A100 GPU 的访问,使他们能够为 COP28 训练他们的开源 LLM ClimateGPT。

- 来自 BotifyMe 的 Arun Reddy 强调了 Lumino 与其他选项相比,以更低的成本为 Llama2 和 Mistral 模型提供的快速微调功能。

- 来自 Twig 的 Chandan Maruthi 赞赏 Lumino 以合理的价格即时访问 GPU,这促使他们选择 Lumino 来满足他们的微调需求。

- 来自 Butternut AI 的 Pritika Mehta 发现 Lumino 易于使用,并对与他们合作开展未来的培训计划感到兴奋。

出租您的 GPU 并赚钱

Lumino 还提供了一种协议,允许用户出租他们的 GPU 并赚钱。这提供了一个将闲置 GPU 资源货币化并为 Lumino 生态系统做出贡献的机会。

为什么 Lumino 很重要?

Lumino 很重要,因为它使 AI 训练资源的访问民主化,使其对更广泛的用户来说更经济实惠和可访问。通过提供用户友好的平台并优化资源利用率,Lumino 使个人和组织能够释放 AI 和机器学习的潜力。

"Lumino"的最佳替代工具

发现DataChain,一个AI原生平台,用于策划、丰富和版本化多模态数据集,如视频、音频、PDF和MRI扫描。它通过ETL管道、数据血统和可扩展处理赋能团队,而无需数据复制。

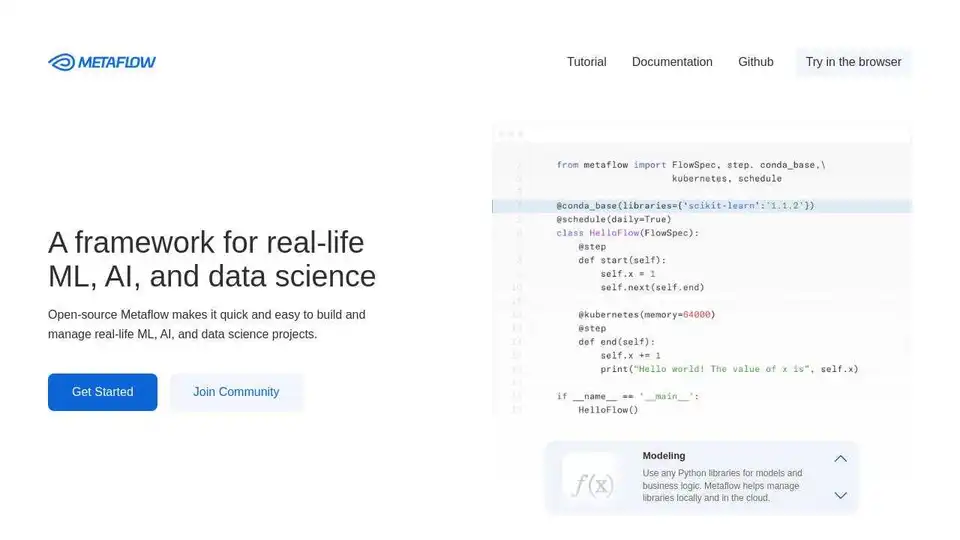

Metaflow是由 Netflix 开源的框架,用于构建和管理真实的 ML、AI 和数据科学项目。轻松扩展工作流程、跟踪实验并部署到生产环境。

Massed Compute 提供用于 AI、机器学习和数据分析的按需 GPU 和 CPU 云计算基础设施。以灵活且经济实惠的计划访问高性能 NVIDIA GPU。

Nebius 是一个旨在普及 AI 基础设施的 AI 云平台,提供灵活的架构、经过测试的性能和长期价值,配备 NVIDIA GPU 和优化的集群,用于训练和推理。

Xander是一个开源桌面平台,支持无代码AI模型训练。只需用自然语言描述任务,即可自动化文本分类、图像分析和LLM微调流程,在本地机器上确保隐私和性能。

SaladCloud 提供经济高效、安全且社区驱动的分布式 GPU 云,用于 AI/ML 推理。节省高达 90% 的计算成本。非常适合 AI 推理、批量处理等。

Baseten 是一个用于在生产环境中部署和扩展 AI 模型的平台。它提供高性能的模型运行时、跨云高可用性和无缝的开发者工作流程,由 Baseten 推理堆栈提供支持。

免费在线试用DeepSeek V3,无需注册。这个强大的开源AI模型拥有671B参数,支持商业使用,并通过浏览器演示或GitHub本地安装提供无限访问。