Thunder Compute 概述

Thunder Compute:经济实惠且易于使用的GPU云平台

什么是Thunder Compute?

Thunder Compute是一个GPU云平台,专为从事AI和机器学习项目的研究人员、初创公司和数据科学家而设计。它提供一键式GPU实例,价格明显更实惠,声称比AWS等竞争对手便宜80%。这使得访问执行高要求的AI/ML任务所需的计算能力变得更容易、更具成本效益。

Thunder Compute如何工作?

Thunder Compute简化了设置和管理GPU实例的过程。用户可以在几秒钟内启动专用GPU,并在流行的代码编辑器VS Code中直接开发。主要功能包括:

- 一键设置: 快速启动GPU实例,无需复杂的配置。

- VS Code集成: 直接从您熟悉的VS Code环境中开发和部署。

- 硬件灵活性: 轻松更换硬件配置以满足您的项目需求。

- 持久环境: 保持一致的开发环境。

主要特点和优势

- 节省成本: 该平台提供按需定价,远低于AWS,使开发人员能够在强大的GPU(如A100)上进行开发,而无需耗尽资金。

- 简化设置: Thunder Compute消除了传统GPU设置的复杂性,无需SSH密钥、CUDA安装和手动依赖项管理。

- 快速开发: VS Code扩展和实例模板简化了开发过程,使用户可以在几秒钟而不是几天内启动并运行他们的项目。

- 可扩展性: 只需点击几下即可轻松更改实例规范(vCPU、RAM、存储),以适应不断变化的项目需求。

- 实例模板: 预配置的模板可用于Ollama和Comfy-ui等流行工具,使用户能够快速开始使用他们喜欢的框架。

Thunder Compute适合哪些人?

Thunder Compute非常适合:

- 研究人员: 访问经济实惠的GPU资源,用于AI/ML研究项目。

- 初创公司: 降低基础设施成本,并加速AI驱动应用程序的开发。

- 数据科学家: 快速原型设计和扩展机器学习模型。

- 机器学习工程师: 简化开发和部署流程。

为什么Thunder Compute很重要?

Thunder Compute普及了GPU计算的访问,使其对于更广泛的用户而言更经济实惠且更容易使用。通过简化GPU实例的设置和管理,Thunder Compute使开发人员能够专注于构建创新的AI/ML应用程序,而不受成本或复杂性的限制。

用户评价

- “VS Code扩展帮助我更快地迭代。任何能减轻论文截止日期压力的东西都是一种胜利。” - 机器学习博士,加州大学伯克利分校

- “我的交付速度更快,我们的CEO喜欢节省的成本。到目前为止,我已经说服了我们九位MLE工程师进行切换。” - ML工程师,B轮初创公司

- “其价值令人难以置信。我们是自筹资金,并且全天候运行2-3个微调作业。” - 数据科学咨询公司联合创始人

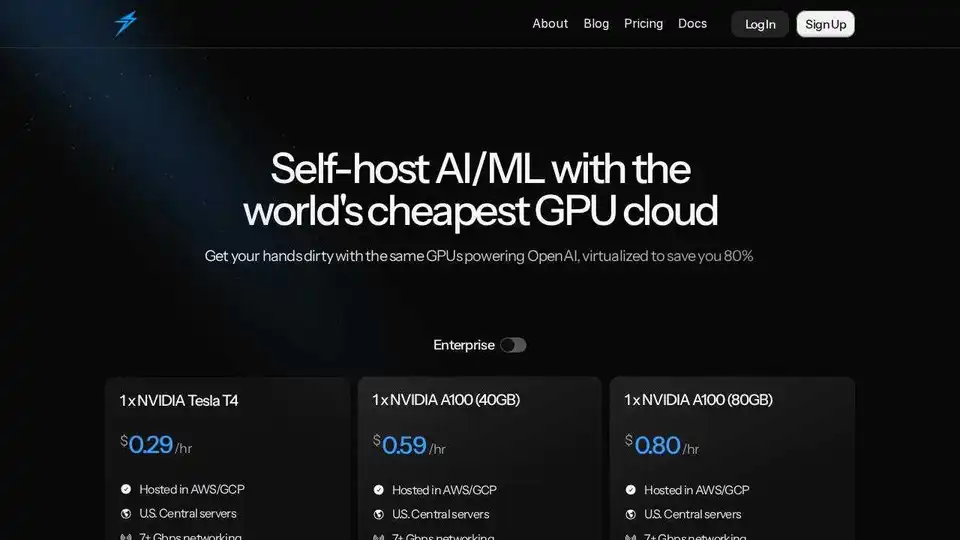

定价

Thunder Compute为各种GPU配置提供具有竞争力的按需定价,包括:

- Tesla T4

- A100 40GB

- A100 80GB

用户可以自定义vCPU、RAM和存储以满足其特定需求。在beta期间,Thunder Compute将匹配首次信用购买的100%,最高可达50美元。

总之,Thunder Compute为任何寻求经济实惠且易于使用的GPU计算以进行AI/ML开发的人员提供了一个引人注目的解决方案。其一键式设置、VS Code集成和具有竞争力的定价使其成为研究人员、初创公司和数据科学家的宝贵工具。

"Thunder Compute"的最佳替代工具

SaladCloud 提供经济高效、安全且社区驱动的分布式 GPU 云,用于 AI/ML 推理。节省高达 90% 的计算成本。非常适合 AI 推理、批量处理等。

GreenNode提供全面的AI就绪基础设施和云解决方案,配备H100 GPU,起价为每小时2.34美元。 访问预配置的实例和完整的AI平台,开启您的AI之旅。

Lightning AI是一个一体化云工作空间,旨在构建、部署和训练AI代理、数据和AI应用程序。只需一个订阅即可获得模型API、GPU训练和多云部署。

ChatLLaMA 是基于 LLaMA 模型的 LoRA 训练 AI 助手,可在本地 GPU 上运行自定义个人对话。提供桌面 GUI,使用 Anthropic 的 HH 数据集训练,支持 7B、13B 和 30B 模型。

Deep Infra 是一个低成本、可扩展的 AI 推理平台,支持 100 多个 ML 模型,如 DeepSeek-V3.2、Qwen 和 OCR 工具。提供开发者友好 API、GPU 租赁、零数据保留和美国安全基础设施,用于生产 AI 工作负载。

Massed Compute 提供用于 AI、机器学习和数据分析的按需 GPU 和 CPU 云计算基础设施。以灵活且经济实惠的计划访问高性能 NVIDIA GPU。

dstack 是一个开源 AI 容器编排引擎,为 ML 团队提供统一的控制平面,用于在云、Kubernetes 和本地环境中进行 GPU 资源调配和编排。简化开发、训练和推理。

Metaflow是由 Netflix 开源的框架,用于构建和管理真实的 ML、AI 和数据科学项目。轻松扩展工作流程、跟踪实验并部署到生产环境。

eeat 是一款由 GPT-3.5 和 GPT-4 驱动的 AI 分析工具,可深入收集商业关键词和竞争对手数据,帮助创建符合 EEAT 标准的专家内容,提升搜索引擎排名和业务竞争力。

Falcon LLM 是 TII 的开源生成式大语言模型家族,包括 Falcon 3、Falcon-H1 和 Falcon Arabic 等,支持多语言、多模态 AI 应用,可在日常设备上高效运行。

Float16.Cloud提供无服务器GPU,以实现快速AI开发。无需设置即可立即运行、训练和扩展AI模型。具有H100 GPU、按秒计费和Python执行功能。