xMem 概述

什么是 xMem?

xMem 是 LLM(大型语言模型)的内存编排器,它结合了长期知识和实时上下文,以创建更智能、更相关的 AI 应用程序。

如何使用 xMem?

使用 API 或仪表板将 xMem 集成到您的 LLM 应用程序中。 xMem 自动为每次 LLM 调用组装最佳上下文,无需手动调整。

const orchestrator = new xmem({

vectorStore: chromadb,

sessionStore: in-memory,

llmProvider: mistral

});

const response = await orchestrator.query({

input: "Tell me about our previous discussion"

});

为什么 xMem 很重要?

LLM 经常忘记会话之间的信息,导致不良的用户体验。 xMem 通过为每个用户提供持久内存来解决这个问题,确保 AI 始终是相关的、准确的和最新的。

主要特点:

- 长期记忆: 使用向量搜索存储和检索知识、笔记和文档。

- 会话记忆: 跟踪最近的聊天、指令和上下文以进行最近和个性化。

- RAG 编排: 自动为每次 LLM 调用组装最佳上下文。 无需手动调整。

- 知识图谱: 实时可视化概念、事实和用户上下文之间的连接。

好处:

- 永远不会丢失会话之间的知识或上下文。

- 通过编排的上下文提高 LLM 准确性。

- 适用于任何开源 LLM 和向量数据库。

- 简单的 API 和仪表板,可实现无缝集成和监控。

"xMem"的最佳替代工具

Cheshire Cat AI 是一个简化 AI 代理构建的开源框架。它支持 LLM、外部 API 和插件,所有这些都在 Docker 化的环境中,便于部署和自定义。

Botpress 是一个由最新 LLM 提供支持的完整 AI 代理平台。 它使您能够构建、部署和管理用于客户支持、内部自动化等的 AI 代理,并具有无缝集成功能。

使用 llama.cpp 实现高效的 LLM 推理,这是一个为各种硬件优化的 C/C++ 库,支持量化、CUDA 和 GGUF 模型。 非常适合本地和云部署。

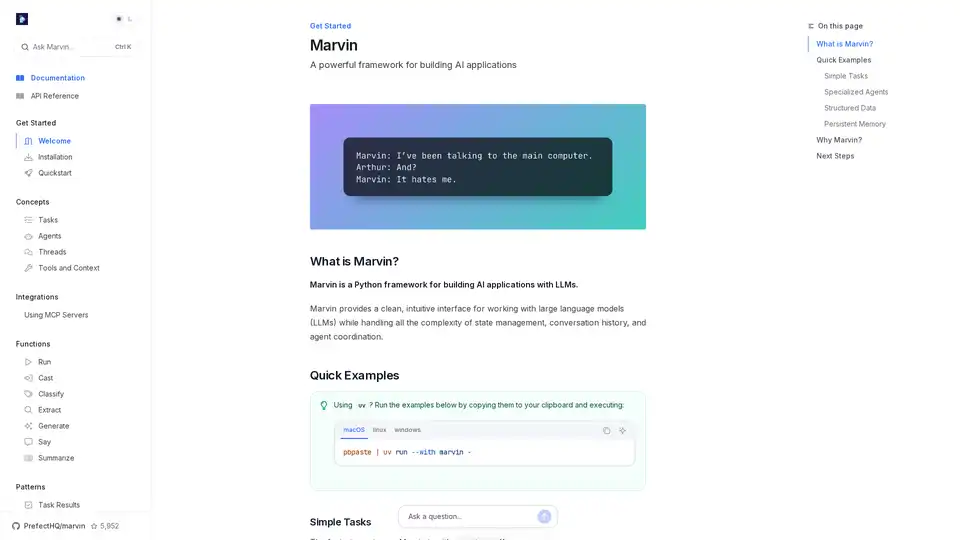

Marvin 是一个强大的 Python 框架,用于使用大语言模型 (LLM) 构建 AI 应用。它简化了状态管理、代理协调和结构化输出,适用于开发者创建智能应用。

Cerebrium是一个无服务器AI基础设施平台,通过低延迟、零DevOps和按秒计费,简化了实时AI应用程序的部署。在全球范围内部署LLM和视觉模型。

Supermemory 是一个快速的记忆 API 和路由器,可为您的 LLM 应用添加长期记忆。使用 Supermemory SDK 和 MCP 在几毫秒内存储、调用和个性化设置。

Toolhouse 是一个云基础设施,可为 LLM 提供操作和知识。只需 3 行代码即可构建和部署具有抓取工具、网络搜索等的 AI 代理。