Llama Family

Übersicht von Llama Family

Llama Familie: Das Open-Source AI Modell-Ökosystem

Was ist die Llama Familie? Die Llama Familie ist eine Open-Source-Community, die sich der Förderung der Entwicklung von Artificial General Intelligence (AGI) durch gemeinsame Anstrengungen rund um Llama-Modelle und verwandte Technologien widmet. Sie zielt darauf ab, eine Plattform zu schaffen, auf der Entwickler und Enthusiasten zu einem Open-Source-Ökosystem beitragen können, das verschiedene Aspekte von AI umfasst, von grossen Modellen bis hin zu kleineren, von Text bis zu multimodalen Fähigkeiten und von Software bis hin zu Hardware-Algorithmusoptimierungen.

Hauptkomponenten der Llama Familie

Modelle: Die Community konzentriert sich auf verschiedene von Meta Open-Sourced Llama-Modelle, darunter Llama, Llama 2, Llama 3, Code Llama und Atom. Diese Modelle decken eine Reihe von Parametergrössen und Trainingsdatensätzen ab und bedienen verschiedene Anwendungsfälle und Forschungsrichtungen.

Compute: Die Community fördert die Zusammenarbeit und den Ressourcenaustausch für Modelltraining und -experimente. Dies beinhaltet die Nutzung von GPU-Ressourcen wie GeForce RTX-Serie, NVIDIA H100 und A100 Tensor Core GPUs.

Community: Das Herzstück der Llama Familie ist ihre lebendige Community von Entwicklern, Forschern und Enthusiasten. Die Community fördert die Zusammenarbeit, den Wissensaustausch und die gemeinsame Entwicklung von Ressourcen und Tools.

Llama Modelle

Meta Llama

Das von Meta Open-Sourced Llama-Modell ist in Industrie und Wissenschaft weit verbreitet. Zu den Versionen gehören 1B, 3B, 8B, 70B und 405B, wobei die Trainingsdaten 15.0T Tokens übersteigen. Vision-Modelle umfassen 11B und 90B, trainiert auf über 6 Milliarden Bild-Text-Paaren.

| Model | Training Data | Params | Tokens | Release Date |

|---|---|---|---|---|

| LLaMA | English CommonCrawl, C4, Github, Wikipedia, Gutenberg and Books3, ArXiv, Stack Exchange | 7B (6.7B) | 1.0T | 2023/02/24 |

| 13B (13.0B) | 1.0T | |||

| 33B (32.5B) | 1.4T | |||

| 65B (65.2B) | 1.4T | |||

| Llama 2 | A new mix of publicly available online data | 7B | 2.0T | 2023/07/18 |

| 13B | 2.0T | |||

| 34B | 2.0T | |||

| 70B | 2.0T | |||

| Llama 3 | A new mix of publicly available online data | 8B | 15.0T | 2024/04/18 |

| 70B | 15.0T | |||

| Llama 3.1 | Collected from publicly available sources, over 5% of the Llama 3 pretraining dataset consists of high-quality non-English data that covers over 30 languages | 8B | 15.0T | 2024/07/23 |

| 70B | 15.0T | |||

| 405B | 15.0T | |||

| Llama 3.2 | Llama 3.2-Text: A new mix of publicly available online data | 1B (1.23B) | 9.0T | 2024/09/25 |

| 3B (3.21B) | 9.0T | |||

| Llama 3.2-Vision | Pretrained on image and text pairs. The instruction tuning data includes publicly available vision instruction datasets, as well as over 3M synthetically generated examples | 11B (10.6B) | 6B (image, text) pairs | |

| 90B (88.8B) | 6B (image, text) pairs |

Code Llama

Code Llama wird auf der Grundlage von Llama 2 mit Codedaten trainiert und ist in Base Model, Python Model und Instruct Model kategorisiert, mit Parametergrössen von 7B, 13B, 34B und 70B. Es unterstützt Code-Fortsetzung, -Füllung und anweisungsbasierte Programmierung.

| Model | Training Data | Params | Type |

|---|---|---|---|

| Code Llama | Based on Llama 2, trained using a public code dataset of 500B tokens. To help the model retain natural language understanding skills, 8% of the sample data comes from natural language datasets related to code. | 7B | Base Model: a foundational model for code generation tasks |

| Python: a version specialized for Python | |||

| Instruct: a fine-tuned version with human instructions and self-instruct code synthesis data | |||

| 13B | |||

| 34B | |||

| 70B |

Atom

Atom, das gemeinsam von AtomEcho und Llama Family entwickelt wurde, basiert auf der Llama-Architektur und wurde auf 2.7T chinesischen und mehrsprachigen Korpora trainiert, mit Parametergrössen von 1B, 7B und 13B. Atom verbessert die chinesischen Sprachfähigkeiten des Llama-Modells.

| Model | Training Data | Params | Tokens | Release Date |

|---|---|---|---|---|

| Atom | Chinese and multilingual encyclopedias, books, blogs, news, novels, financial data, legal data, medical data, code, paper, Chinese NLP competition datasets, etc. | 1B | 2.7T | 2023/12/20 |

| 7B | 2.7T | 2023/08/28 | ||

| 13B | 2.7T | 2023/07/31 |

Wie man zur Llama Familie beitragen kann

- Der Community beitreten: Interagieren Sie mit anderen Entwicklern und Enthusiasten über Foren, Chatgruppen und Veranstaltungen.

- Code beitragen: Senden Sie Pull-Requests mit Fehlerbehebungen, neuen Funktionen oder Modellverbesserungen.

- Ressourcen teilen: Teilen Sie Datensätze, Trainingsskripte und vortrainierte Modelle mit der Community.

- Feedback geben: Geben Sie Feedback zu bestehenden Modellen und Tools, um deren Qualität und Benutzerfreundlichkeit zu verbessern.

Warum ist die Llama Familie wichtig?

Die Llama Familie ist wichtig, weil sie die Zusammenarbeit fördert und die Entwicklung von Open-Source-AI-Modellen beschleunigt. Indem sie eine Plattform für Entwickler und Forscher bietet, um Ressourcen und Wissen auszutauschen, trägt die Llama Familie dazu bei, den Zugang zu AI-Technologie zu demokratisieren und Innovationen zu fördern.

Fazit

Die Llama Familie ist eine wachsende Community, die sich der Weiterentwicklung von AI durch Open-Source-Zusammenarbeit widmet. Treten Sie noch heute der Llama Familie bei, um zur Zukunft von AI beizutragen!

Beste Alternativwerkzeuge zu "Llama Family"

Mit Replicate können Sie Open-Source-Modelle für maschinelles Lernen mit einer Cloud-API ausführen und optimieren. Erstellen und skalieren Sie KI-Produkte mit Leichtigkeit.

ChatLLaMA ist ein LoRA-trainierter KI-Assistent basierend auf LLaMA-Modellen, der benutzerdefinierte persönliche Gespräche auf Ihrem lokalen GPU ermöglicht. Mit Desktop-GUI, trainiert auf Anthropics HH-Datensatz, verfügbar für 7B-, 13B- und 30B-Modelle.

Falcon LLM ist eine Open-Source-Familie generativer großer Sprachmodelle von TII, mit Modellen wie Falcon 3, Falcon-H1 und Falcon Arabic für mehrsprachige, multimodale KI-Anwendungen, die effizient auf Alltagsgeräten laufen.

LM Studio ist eine benutzerfreundliche Desktop-Anwendung zum lokalen Ausführen und Herunterladen von Open-Source-Sprachmodellen (LLMs) wie LLaMa und Gemma auf Ihrem Computer. Es bietet eine In-App-Chat-Benutzeroberfläche und einen OpenAI-kompatiblen Server für die Offline-KI-Modellinteraktion, wodurch fortschrittliche KI ohne Programmierkenntnisse zugänglich wird.

Sesame AI zielt darauf ab, in der KI „Sprachpräsenz“ zu erreichen, wodurch gesprochene Interaktionen sich real und verständlich anfühlen. Entdecken Sie ihr Conversational Speech Model (CSM) für einen natürlichen Dialog.

Arbius ist ein dezentrales Netzwerk, das von GPUs weltweit betrieben wird und eine gemeinsame Wirtschaft rund um generative KI schafft. Es ermöglicht Benutzern, an der Governance teilzunehmen, Gebühren durch Staking zu verdienen und offene KI zu fördern.

Der Nebius AI Studio Inference Service bietet gehostete Open-Source-Modelle für schnellere, günstigere und genauere Ergebnisse als proprietäre APIs. Skalieren Sie nahtlos ohne MLOps, ideal für RAG und Produktionsworkloads.

xTuring ist eine Open-Source-Bibliothek, die Benutzern ermöglicht, Large Language Models (LLMs) effizient anzupassen und zu optimieren, mit Fokus auf Einfachheit, Ressourcenoptimierung und Flexibilität für die KI-Personalisierung.

Ermöglichen Sie eine effiziente LLM-Inferenz mit llama.cpp, einer C/C++-Bibliothek, die für verschiedene Hardware optimiert ist und Quantisierung, CUDA und GGUF-Modelle unterstützt. Ideal für lokale und Cloud-Bereitstellung.

AskCodi ist eine KI-gestützte API-Plattform, die die Codeentwicklung vereinfacht, indem sie über eine einzige Schnittstelle Zugriff auf mehrere KI-Modelle wie GPT-4, Claude und Gemini bietet. Optimieren Sie Ihren Workflow und erstellen Sie intelligentere Anwendungen.

Jan ist ein Open-Source-KI-Client, der in erster Linie offline funktioniert. Führen Sie Large Language Models (LLMs) lokal mit Datenschutz und ohne API-Gebühren aus. Verbinden Sie sich mit verschiedenen Modellen und Diensten.

Interacly ist eine Open-Source-KI-Super-App, mit der Sie KI-Agenten erstellen, anpassen und mit ihnen zusammenarbeiten können. Diese datenschutzorientierte Plattform bietet natürliche Konversationen, Automatisierung und Entwicklungstools.

Entdecken Sie das Awesome ChatGPT Prompts-Repo, eine kuratierte Sammlung von Prompts, um ChatGPT und andere LLMs wie Claude und Gemini für Aufgaben von Schreiben bis Codieren zu optimieren. Verbessern Sie AI-Interaktionen mit bewährten Beispielen.

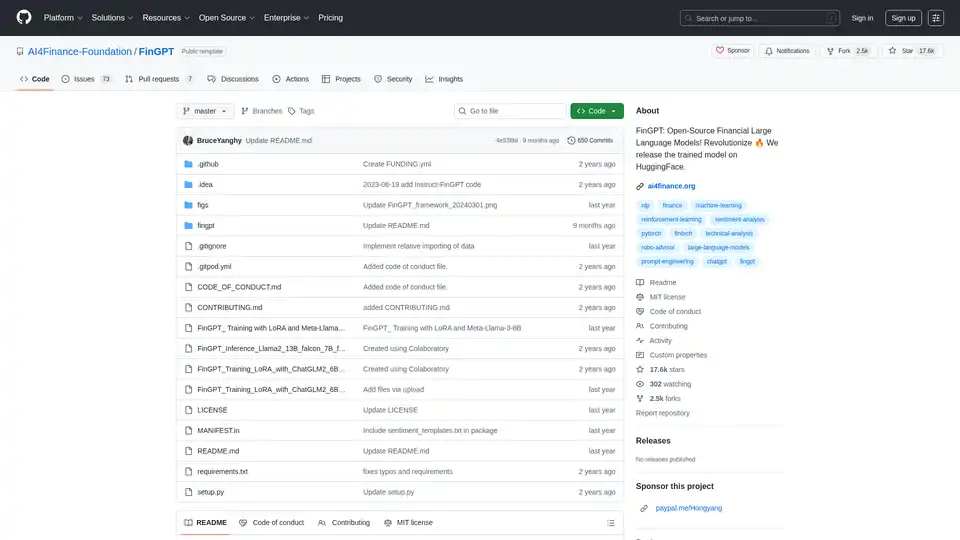

FinGPT: Ein Open-Source-Finanz-Large-Language-Modell zur Demokratisierung von Finanzdaten, Sentimentanalyse und Prognose. Schnelle Feinabstimmung für zeitnahe Markteinblicke.