Selene

Descripción general de Selene

Selene de Atla AI: Modelos de Evaluación de IA de Frontera

¿Qué es Selene?

Selene es un conjunto de modelos LLM Judge de código abierto desarrollados por Atla AI, diseñados para proporcionar evaluaciones precisas y confiables del rendimiento de las aplicaciones de AI. Ayuda a los desarrolladores a generar confianza con los clientes al garantizar la fiabilidad de sus aplicaciones de AI generativa a través de puntuaciones detalladas y críticas prácticas.

¿Cómo funciona Selene?

Los modelos Selene funcionan como LLM-as-a-Judge, analizando las respuestas de AI para proporcionar puntuaciones y críticas. Puede utilizar los modelos Selene a través de Hugging Face Transformers, Ollama o Github.

Modelos Selene

Explore el tamaño adecuado para sus necesidades de evaluación con dos modelos principales:

- Selene 1: El modelo insignia que ofrece una precisión líder en la industria en una amplia variedad de tareas de evaluación. Ideal para evaluaciones previas a la producción.

- Selene 1 Mini: Una versión ligera y optimizada perfecta para ejecutar evaluaciones en tiempo de inferencia, priorizando la velocidad y la eficiencia.

Características y Beneficios Clave

- Alta Precisión: Selene está diseñado para proporcionar las evaluaciones más precisas disponibles.

- Evaluación Versátil: Adecuado para una amplia variedad de tareas de evaluación.

- Optimizado para la Velocidad: Selene 1 Mini está optimizado para ejecutar evaluaciones rápidamente durante la inferencia.

- Código Abierto: Use y contribuya a los modelos a través de Hugging Face Transformers.

Cómo Usar Selene

Para usar Selene, puede aprovechar la biblioteca Hugging Face Transformers. Aquí hay un ejemplo simple:

from transformers import AutoModelForCausalLM, AutoTokenizer

device = "cuda" # el dispositivo para cargar el modelo

model_id = "AtlaAI/Selene-1-Mini-Llama-3.1-8B"

model = AutoModelForCausalLM.from_pretrained(model_id, device_map="auto")

tokenizer = AutoTokenizer.from_pretrained(model_id)

prompt = "Escuché que puedes evaluar mis respuestas?" # reemplaza con tu prompt de evaluación

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(device)

generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=True)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

Casos de Uso

- Evaluación del Rendimiento del Agente: Use Selene para evaluar el rendimiento de los agentes de AI, rastrear errores y obtener información instantánea.

- Generación de Confianza: Asegure la fiabilidad de su aplicación de AI generativa para generar confianza con los clientes.

- Evaluaciones Previas a la Producción: Use Selene 1 para evaluaciones rigurosas antes de implementar su aplicación de AI.

- Evaluaciones en Tiempo de Inferencia: Use Selene 1 Mini para evaluaciones rápidas durante la inferencia.

¿Por qué es importante Selene?

A medida que las aplicaciones de AI se vuelven más frecuentes, asegurar su fiabilidad y confiabilidad es crucial. Selene proporciona un medio robusto y preciso para evaluar el rendimiento de AI, lo que permite a los desarrolladores crear sistemas de AI más seguros y confiables. Es particularmente importante para generar confianza con los clientes, especialmente en las aplicaciones de AI generativa donde las salidas pueden ser impredecibles.

¿Dónde puedo usar Selene?

Puede integrar Selene en su flujo de trabajo de desarrollo de AI utilizando Hugging Face Transformers. Además, puede explorar Agent Evals by Atla para mejorar y rastrear Agentes.

Al proporcionar modelos de evaluación de código abierto, Atla AI contribuye a un futuro con AI segura y confiable.

Mejores herramientas alternativas a "Selene"

Query Vary es una plataforma sin código que permite a los equipos entrenar IA de forma colaborativa y construir automatizaciones impulsadas por IA. Integra IA generativa para optimizar los flujos de trabajo y mejorar la productividad sin programación.

Parea AI es una plataforma de experimentación y anotación de IA que ayuda a los equipos a enviar aplicaciones LLM con confianza. Ofrece funciones para el seguimiento de experimentos, la observabilidad, la revisión humana y la implementación rápida.

Scale AI proporciona datos de entrenamiento de alta calidad y soluciones de IA de pila completa para empresas y gobiernos, acelerando el desarrollo de aplicaciones de IA. Con la confianza de empresas de talla mundial.

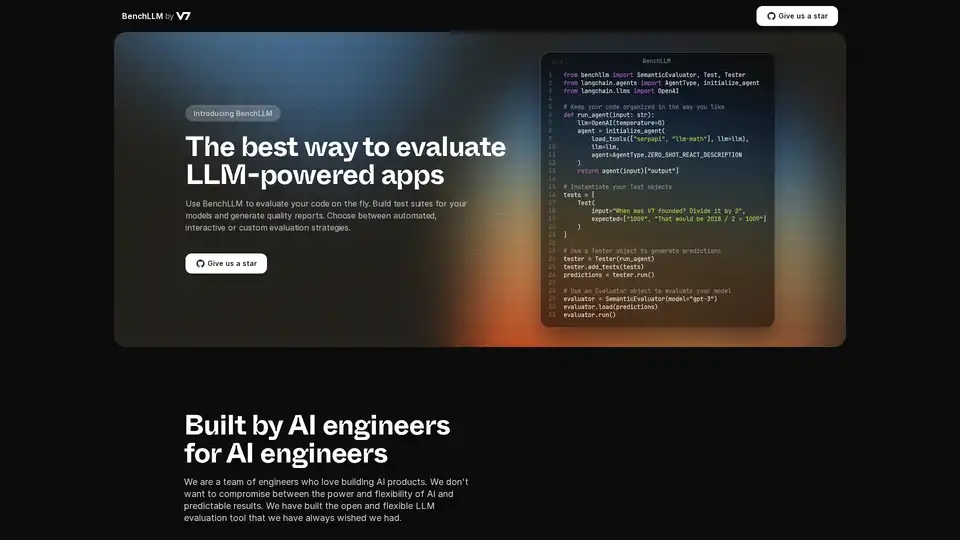

BenchLLM es una herramienta de código abierto para evaluar aplicaciones impulsadas por LLM. Cree conjuntos de pruebas, genere informes y supervise el rendimiento del modelo con estrategias automatizadas, interactivas o personalizadas.

Teammately es el Agente de IA para Ingenieros de IA, automatizando y acelerando cada paso en la construcción de IA confiable a escala. Construye IA de grado de producción más rápido con generación de prompts, RAG y observabilidad.

Maxim AI es una plataforma integral de evaluación y observabilidad que ayuda a los equipos a implementar agentes de IA de manera confiable y 5 veces más rápido con herramientas completas de prueba, monitoreo y garantía de calidad.

Parea AI es la plataforma definitiva de experimentación y anotación humana para equipos de IA, que permite una evaluación fluida de LLM, pruebas de prompts y despliegue en producción para construir aplicaciones de IA confiables.

Coxwave Align permite a las organizaciones modernas analizar y evaluar fácilmente datos de productos conversacionales basados en LLM.

Arize AI proporciona una plataforma unificada de observabilidad LLM y evaluación de agentes para aplicaciones de IA, desde el desarrollo hasta la producción. Optimice las indicaciones, rastree agentes y monitoree el rendimiento de la IA en tiempo real.

Bolt Foundry proporciona herramientas de ingeniería de contexto para hacer que el comportamiento de la IA sea predecible y comprobable, ayudándole a construir productos LLM confiables. Pruebe los LLM como si probara el código.

Openlayer es una plataforma de IA empresarial que proporciona evaluación, observabilidad y gobernanza de IA unificadas para sistemas de IA, desde ML hasta LLM. Pruebe, supervise y gestione los sistemas de IA durante todo el ciclo de vida de la IA.

Confident AI: Plataforma de evaluación LLM DeepEval para probar, evaluar y mejorar el rendimiento de las aplicaciones LLM.

LangWatch es una plataforma de prueba de agentes de IA, evaluación de LLM y observabilidad de LLM. Pruebe agentes, prevenga regresiones y depure problemas.

Future AGI ofrece una plataforma unificada de observabilidad LLM y evaluación de agentes de IA para aplicaciones de IA, garantizando precisión e IA responsable desde el desarrollo hasta la producción.