Selene

Vue d'ensemble de Selene

Selene par Atla AI : Modèles d’évaluation d’IA de pointe

Qu’est-ce que Selene ?

Selene est une suite de modèles LLM Judge open source développés par Atla AI, conçus pour fournir des évaluations précises et fiables des performances des applications d’IA. Elle aide les développeurs à établir la confiance avec les clients en garantissant la fiabilité de leurs applications d’IA générative grâce à des scores détaillés et à des critiques exploitables.

Comment fonctionne Selene ?

Les modèles Selene fonctionnent comme LLM-as-a-Judge, en analysant les réponses de l’IA pour fournir des scores et des critiques. Vous pouvez utiliser les modèles Selene via Hugging Face Transformers, Ollama ou Github.

Modèles Selene

Découvrez la taille adaptée à vos besoins d’évaluation avec deux modèles principaux :

- Selene 1: Le modèle phare offrant une précision inégalée dans l’industrie pour une grande variété de tâches d’évaluation. Idéal pour les évaluations de préproduction.

- Selene 1 Mini: Une version allégée et optimisée, parfaite pour exécuter des évaluations au moment de l’inférence, en privilégiant la vitesse et l’efficacité.

Principales fonctionnalités et avantages

- Haute précision: Selene est conçu pour fournir les évaluations les plus précises disponibles.

- Évaluation polyvalente: Convient à une grande variété de tâches d’évaluation.

- Optimisé pour la vitesse: Selene 1 Mini est optimisé pour exécuter rapidement des évaluations pendant l’inférence.

- Open source: Utilisez les modèles et contribuez à leur développement via Hugging Face Transformers.

Comment utiliser Selene

Pour utiliser Selene, vous pouvez exploiter la bibliothèque Hugging Face Transformers. Voici un exemple simple :

from transformers import AutoModelForCausalLM, AutoTokenizer

device = "cuda" # l’appareil sur lequel charger le modèle

model_id = "AtlaAI/Selene-1-Mini-Llama-3.1-8B"

model = AutoModelForCausalLM.from_pretrained(model_id, device_map="auto")

tokenizer = AutoTokenizer.from_pretrained(model_id)

prompt = "J’ai entendu dire que vous pouviez évaluer mes réponses ?" # remplacez par votre invite d’évaluation

messages = [{« role »: « user », « content »: prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors=« pt »).to(device)

generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=True)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

Cas d’utilisation

- Évaluation des performances des agents: Utilisez Selene pour évaluer les performances des agents d’IA, suivre les erreurs et obtenir des informations instantanées.

- Établir la confiance: Assurez la fiabilité de votre application d’IA générative pour établir la confiance avec les clients.

- Évaluations de préproduction: Utilisez Selene 1 pour des évaluations rigoureuses avant de déployer votre application d’IA.

- Évaluations au moment de l’inférence: Utilisez Selene 1 Mini pour des évaluations rapides pendant l’inférence.

Pourquoi Selene est-il important ?

À mesure que les applications d’IA se généralisent, il est essentiel de garantir leur fiabilité et leur crédibilité. Selene fournit un moyen robuste et précis d’évaluer les performances de l’IA, permettant aux développeurs de créer des systèmes d’IA plus sûrs et plus fiables. Il est particulièrement important d’établir la confiance avec les clients, en particulier dans les applications d’IA générative où les résultats peuvent être imprévisibles.

Où puis-je utiliser Selene ?

Vous pouvez intégrer Selene à votre flux de travail de développement d’IA à l’aide de Hugging Face Transformers. Vous pouvez également explorer Agent Evals by Atla pour améliorer et suivre les agents.

En fournissant des modèles d’évaluation open source, Atla AI contribue à un avenir avec une IA sûre et fiable.

Meilleurs outils alternatifs à "Selene"

Query Vary est une plateforme sans code qui permet aux équipes de former l'IA en collaboration et de créer des automatisations basées sur l'IA. Il intègre l'IA générative pour optimiser les flux de travail et améliorer la productivité sans programmation.

Parea AI est une plateforme d'expérimentation et d'annotation d'IA qui aide les équipes à déployer en toute confiance des applications LLM. Elle offre des fonctionnalités pour le suivi des expériences, l'observabilité, la révision humaine et le déploiement rapide.

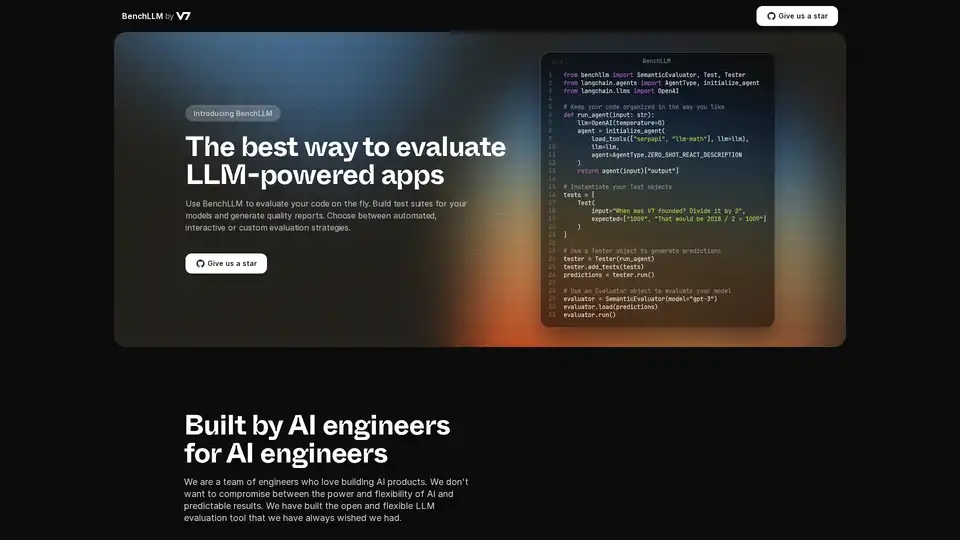

BenchLLM est un outil open source pour évaluer les applications optimisées par LLM. Créez des suites de tests, générez des rapports et surveillez les performances du modèle avec des stratégies automatisées, interactives ou personnalisées.

Teammately est l'agent IA pour les ingénieurs IA, automatisant et accélérant chaque étape de la construction d'une IA fiable à l'échelle. Construisez une IA de qualité production plus rapidement grâce à la génération d'invites, au RAG et à l'observabilité.

Maxim AI est une plateforme d'évaluation et d'observabilité de bout en bout qui aide les équipes à déployer des agents IA de manière fiable et 5 fois plus rapidement avec des outils complets de test, de surveillance et d'assurance qualité.

Parea AI est la plateforme ultime d'expérimentation et d'annotation humaine pour les équipes d'IA, permettant une évaluation fluide des LLM, des tests de prompts et un déploiement en production pour construire des applications d'IA fiables.

Coxwave Align permet aux organisations modernes d'analyser et d'évaluer facilement les données de produits conversationnels basés sur LLM.

Arize AI fournit une plateforme unifiée d'observabilité LLM et d'évaluation d'agents pour les applications d'IA, du développement à la production. Optimisez les invites, suivez les agents et surveillez les performances de l'IA en temps réel.

Bolt Foundry fournit des outils d'ingénierie contextuelle pour rendre le comportement de l'IA prévisible et testable, vous aidant ainsi à créer des produits LLM fiables. Testez les LLM comme vous testez le code.

Latitude est une plateforme open source pour l'ingénierie des prompts, permettant aux experts de domaine de collaborer avec les ingénieurs pour fournir des fonctionnalités LLM de qualité production. Construisez, évaluez et déployez des produits d'IA en toute confiance.

Openlayer est une plateforme d'IA d'entreprise offrant une évaluation, une observabilité et une gouvernance unifiées de l'IA pour les systèmes d'IA, du ML aux LLM. Testez, surveillez et gouvernez les systèmes d'IA tout au long du cycle de vie de l'IA.

Confident AI: Plateforme d'évaluation LLM DeepEval pour tester, évaluer et améliorer les performances des applications LLM.

LangWatch est une plateforme de test d'agents d'IA, d'évaluation de LLM et d'observabilité de LLM. Testez les agents, prévenez les régressions et corrigez les problèmes.

Future AGI offre une plateforme unifiée d'observabilité LLM et d'évaluation d'agents IA pour les applications d'IA, garantissant la précision et l'IA responsable du développement à la production.