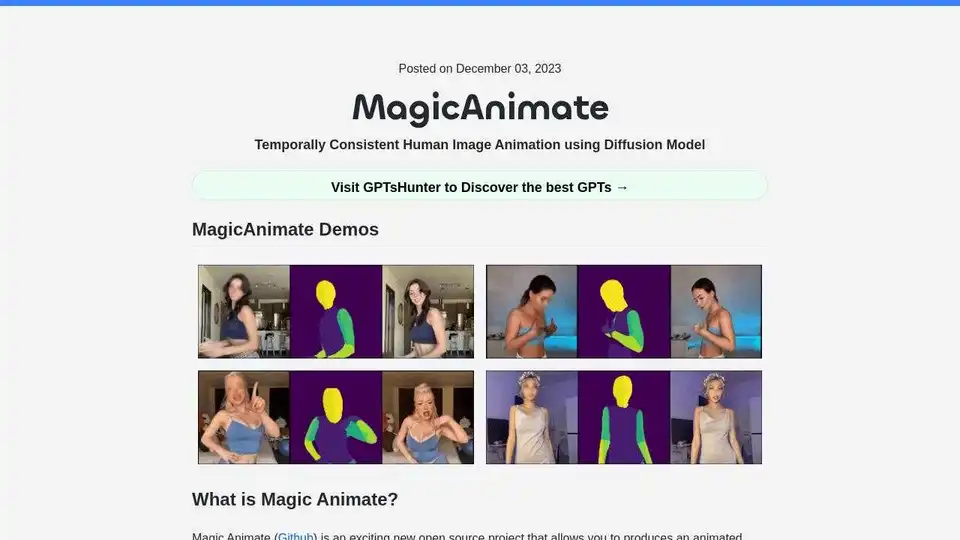

MagicAnimate の概要

MagicAnimate:拡散モデルを用いた時間的に一貫性のある人物画像アニメーション

MagicAnimateは、拡散ベースのフレームワークを使用して、単一の画像とモーションビデオからアニメーションビデオを生成するオープンソースプロジェクトです。時間的な一貫性を維持し、アニメーションの忠実度を高めながら、参照画像を保持することに重点を置いています。このツールは、シンガポール国立大学のShow LabとBytedanceによって開発されました。

MagicAnimateとは?

MagicAnimateは、クロスIDアニメーションや、油絵や映画のキャラクターなどの未見のドメインを含む、さまざまなソースからのモーションシーケンスを使用して参照画像をアニメーション化することに優れています。DALLE3などのテキストから画像への拡散モデルと統合し、テキストプロンプトの画像をダイナミックなアクションで生き生きとさせます。

主な機能と利点:

- 時間的一貫性: アニメーション全体を通して一貫性を維持します。

- 参照画像の保持: 参照画像の詳細を忠実に保持します。

- アニメーションの忠実度の向上: アニメーションの品質とリアリズムを向上させます。

- 汎用性の高いモーションソース: 未見のドメインを含む、さまざまなソースからのモーションシーケンスをサポートします。

- T2Iモデルとの統合: DALLE3などのテキストから画像への拡散モデルと互換性があります。

欠点:

- 顔と手に多少の歪みがあります。

- 顔のスタイルがアニメからリアリズムにシフトします。

- アニメスタイルを実際の人間のビデオに適用すると、体のプロポーションが変化します。

MagicAnimateの始め方:

- 前提条件: Python >= 3.8、CUDA >= 11.3、およびFFmpegがインストールされていることを確認してください。

- インストール:

conda env create -f environment.yml conda activate manimate

MagicAnimateの使い方:

オンラインデモ: Hugging FaceまたはReplicateでMagicAnimateオンラインデモを試してください。

Colab: このチュートリアルを使用して、Google ColabでMagicAnimateを実行します:ColabでMagicAnimateを実行する方法。

Replicate API: Replicate APIを使用して、アニメーションビデオを生成します。

import Replicate from "replicate"; const replicate = new Replicate({ auth: process.env.REPLICATE_API_TOKEN, }); const output = await replicate.run( "lucataco/magic-animate:e24ad72cc67dd2a365b5b909aca70371bba62b685019f4e96317e59d4ace6714", { input: { image: "https://example.com/image.png", video: "Input motion video", num_inference_steps: 25, // Number of denoising steps guidance_scale: 7.5, // Scale for classifier-free guidance seed: 349324 // Random seed. Leave blank to randomize the seed } } );

モーションビデオの生成方法:

- リアルタイムのマルチ人物キーポイント検出ライブラリであるOpenPoseを使用して、ビデオをモーションビデオに変換します。

- このモデルを使用して、モーションビデオをOpenPoseに変換します:ビデオからOpenPose。

- OpenPoseでmagic-animate-openposeモデルを使用します。

追加リソース:

MagicAnimateの主な機能は何ですか?

MagicAnimateの主な機能は、単一の参照画像とモーションビデオからアニメーションビデオを生成し、時間的な一貫性と高い忠実度を保証することです。

MagicAnimateはどのように機能しますか?

MagicAnimateは、拡散ベースのフレームワークを使用して、入力ビデオのモーションを分析し、それを参照画像に適用して、モーションを模倣しながら参照画像の視覚的特性を保持する新しいビデオを生成します。

"MagicAnimate" のベストな代替ツール

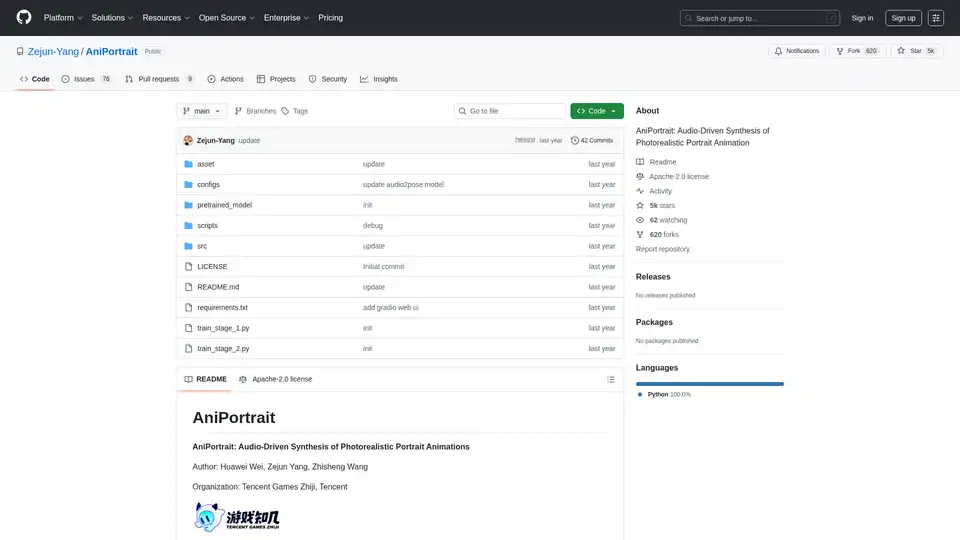

AniPortraitは、オープンソースのAIフレームワークで、音声またはビデオ入力によって駆動されるフォトリアリスティックなポートレートアニメーションを生成します。自駆動、顔再現、オーディオ駆動モードをサポートし、高品質なビデオ合成を実現します。

AnimateDiffは、AI生成のビジュアルに動きを加える無料のオンラインビデオメーカーです。テキストプロンプトからアニメーションを作成したり、既存の画像を実際のビデオから学んだ自然な動きでアニメーション化したりできます。このプラグアンドプレイフレームワークは、Stable Diffusionのような拡散モデルにビデオ機能を追加し、再トレーニング不要です。AnimateDiffのテキスト-to-ビデオと画像-to-ビデオ生成ツールで、AIコンテンツ作成の未来を探求しましょう。

ToonCrafter AI を使用して、写真を魅力的な漫画に変換します。これは、シームレスな漫画の補間とビデオ生成のためのオープンソースの AI ツールです。アニメーション愛好家やクリエイティブ ディレクターに最適です。

Flux AIは、高度なAI画像およびビデオ生成ツールを提供します。 テキストから画像へ、画像からビデオへのテクノロジーを使用して、驚くほど美しいビジュアルを作成します。 Flux Kontext AIとFlux.1 AIモデルを無料でお試しください。

FramePackを使用すると、わずか6GBのVRAMでコンシューマーGPU上で高品質のビデオを生成できます。このオープンソースのビデオ拡散テクノロジーは、フレームコンテキストパッキングを使用して、高速なローカル実行を実現します。

NightCafeを発見、最強の無料AIアート生成器でFluxやDALL-E 3などのトップモデル、活気あるコミュニティ、デイリーチャレンジで終わりのない創造性を。

Anime Art Studio は、100 以上の安定した拡散アニメモデルに 24 時間年中無休でアクセスできる 100% 無料の AI アニメジェネレーターです。テキストを美しいアニメアートに簡単に変換します。

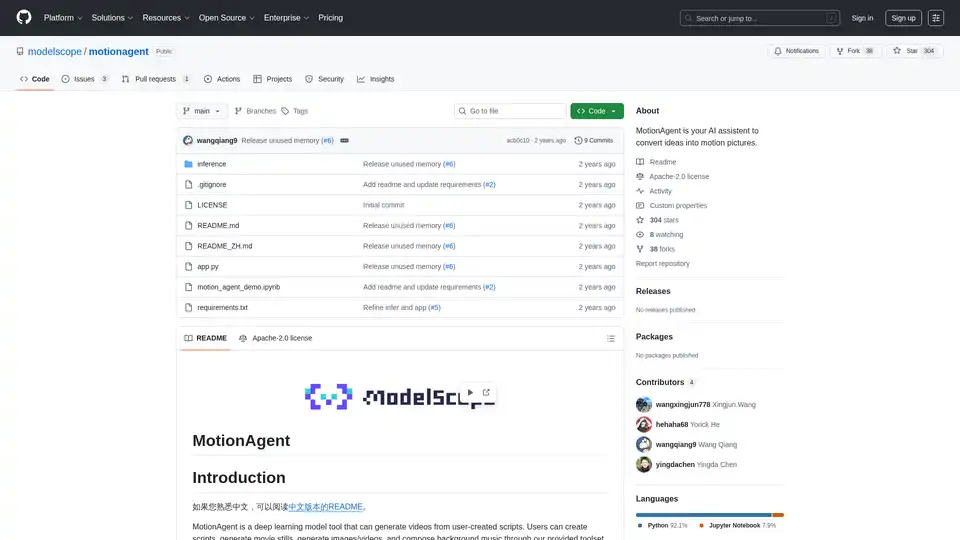

MotionAgent はオープンソースの AI ツールで、Qwen-7B-Chat や SDXL などのモデルを使用して、アイデアを動く映画に変換します。スクリプト、映画の静止画、高解像度ビデオ、カスタム背景音楽を生成します。

オールインワンAIクリエーションツール:テキスト、画像、ビデオ、デジタルヒューマン作成のためのワンストップAIプラットフォーム。高度なAI機能でアイデアを素早く驚くべきビジュアルに変身。

Lumiereは、Google Researchによるビデオ生成のための時空間拡散モデルです。テキストからビデオ、画像からビデオ、ビデオのスタイル化、シネマグラフ、インペインティングをサポートし、リアルで一貫性のあるモーションを生成します。

BestPhotoで普通の写真をプロフェッショナルな傑作に変えましょう。AI写真強化ツールを使用して、素晴らしいヘッドショット、デートプロファイル、ソーシャルメディアコンテンツを作成し、即時高品質な結果を得てください。

Generor.comは、トップAIモデルを使用してビデオ、画像、音声、音楽、コード、ビジネスアイデアなどを生成・管理できる包括的なAIプラットフォームです。クリエイターに最適。

Media.ioのAIビデオジェネレーターで、数秒でアイデアをビデオに変換します。テキストを入力するか画像をアップロードするだけで、水印なしの魅力的なビデオを作成—100%無料。