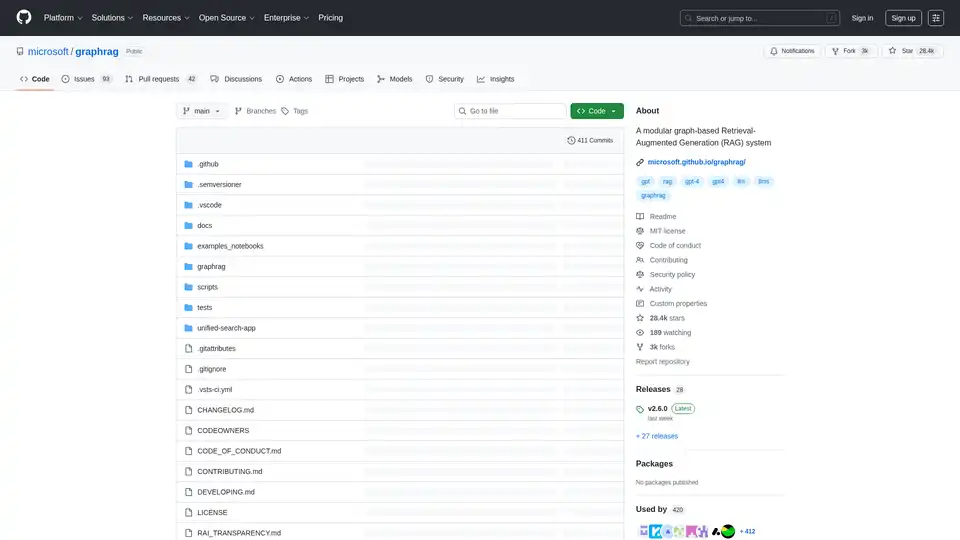

GraphRAG

Übersicht von GraphRAG

GraphRAG: LLMs mit Wissensgraphen verbessern

GraphRAG ist ein Open-Source-Projekt von Microsoft Research, das entwickelt wurde, um die Ausgaben von Large Language Models (LLM) mithilfe von Wissensgraph-Speicherstrukturen zu verbessern. Es handelt sich um eine modulare Datenpipeline und Transformationssuite, die mithilfe der Leistungsfähigkeit von LLMs aussagekräftige, strukturierte Daten aus unstrukturiertem Text extrahiert.

Was ist GraphRAG?

GraphRAG (Graph-based Retrieval-Augmented Generation) ist ein System, das Wissensgraphen verwendet, um die Schlussfolgerungsfähigkeiten von LLMs zu verbessern. Durch die Strukturierung von Informationen in einem Graphformat ermöglicht GraphRAG LLMs den effizienteren Zugriff auf und die Verarbeitung von Daten, was zu besseren und genaueren Ergebnissen führt.

Wie funktioniert GraphRAG?

GraphRAG funktioniert wie folgt:

- Extrahieren von Daten: Es extrahiert Daten aus unstrukturiertem Text mithilfe von LLMs.

- Strukturieren von Daten: Es transformiert die extrahierten Daten in einen Wissensgraphen.

- Verbessern der LLM-Ausgaben: Es verwendet den Wissensgraphen, um die Ausgaben von LLMs zu verbessern.

Hauptmerkmale:

- Modulares Design: GraphRAG ist mit einer modularen Architektur konzipiert, die eine einfache Anpassung und Erweiterung ermöglicht.

- Datenpipeline: Es bietet eine vollständige Datenpipeline zum Extrahieren, Transformieren und Laden von Daten in einen Wissensgraphen.

- LLM-Integration: Es lässt sich nahtlos in LLMs integrieren, um deren Schlussfolgerungsfähigkeiten zu verbessern.

Wie verwende ich GraphRAG?

Um mit GraphRAG zu beginnen, folgen Sie diesen Schritten:

- Installation: Klonen Sie das Repository und installieren Sie die erforderlichen Abhängigkeiten.

- Initialisierung: Führen Sie

graphrag init --root [path] --forceaus, um das System zu initialisieren. - Konfiguration: Konfigurieren Sie das System, um eine Verbindung zu Ihren Datenquellen und LLMs herzustellen.

- Indizierung: Indizieren Sie Ihre Daten, um den Wissensgraphen zu erstellen. Beachten Sie, dass die GraphRAG-Indizierung ein aufwendiger Vorgang sein kann. Lesen Sie die gesamte Dokumentation, um den Prozess und die damit verbundenen Kosten zu verstehen, und beginnen Sie klein.

- Prompt-Tuning: Optimieren Sie Ihre Prompts, um die bestmöglichen Ergebnisse zu erzielen.

Warum GraphRAG wählen?

- Verbessertes Schlussfolgern: GraphRAG verbessert die Schlussfolgerungsfähigkeiten von LLMs und führt zu genaueren und zuverlässigeren Ergebnissen.

- Strukturierte Daten: Es wandelt unstrukturierten Text in strukturierte Wissensgraphen um, wodurch der Zugriff auf und die Verarbeitung von Daten erleichtert wird.

- Open-Source: GraphRAG ist ein Open-Source-Projekt, das Community-Beiträge und -Anpassungen ermöglicht.

Für wen ist GraphRAG geeignet?

GraphRAG ist geeignet für:

- Forscher: Die die Verwendung von Wissensgraphen zur Verbesserung von LLMs untersuchen.

- Entwickler: Die Anwendungen erstellen, die erweiterte Schlussfolgerungsfähigkeiten erfordern.

- Organisationen: Die die Genauigkeit und Zuverlässigkeit ihrer LLM-Ausgaben verbessern möchten.

Beispielhafte Anwendungsfälle:

- Fragebeantwortung: Verbessern Sie die Genauigkeit von Fragebeantwortungssystemen, indem Sie Wissensgraphen nutzen.

- Datenintegration: Integrieren Sie Daten aus mehreren Quellen in einen einheitlichen Wissensgraphen.

- Knowledge Discovery: Entdecken Sie neue Erkenntnisse und Beziehungen in Ihren Daten.

Versionierung:

Führen Sie immer graphrag init --root [path] --force zwischen kleineren Versionssprüngen aus, um sicherzustellen, dass Sie das neueste Konfigurationsformat haben. Führen Sie das bereitgestellte Migrations-Notebook zwischen größeren Versionssprüngen aus, wenn Sie eine Neuindizierung früherer Datensätze vermeiden möchten. Beachten Sie, dass dadurch Ihre Konfiguration und Prompts überschrieben werden. Sichern Sie diese daher bei Bedarf.

Verantwortungsvolle KI: Bitte beachten Sie RAI_TRANSPARENCY.md für Überlegungen zur verantwortungsvollen KI.

Durch die Verwendung von Wissensgraphen ermöglicht GraphRAG LLMs den effizienteren Zugriff auf und die Verarbeitung von Daten, was zu besseren und genaueren Ergebnissen führt. Dies macht es zu einem wertvollen Werkzeug für alle, die die Schlussfolgerungsfähigkeiten ihrer LLMs verbessern möchten.

Beste Alternativwerkzeuge zu "GraphRAG"

xMem beschleunigt LLM-Apps mit Hybrid-Speicher und kombiniert langfristiges Wissen und Echtzeitkontext für intelligentere KI.

Zep ist eine Context-Engineering-Plattform zum Erstellen personalisierter KI-Agenten. Sie verfügt über Agentenspeicher, Graph RAG und automatisierte Kontextzusammenstellung, sodass sich Agenten wichtige Details merken und auf relevante Daten zugreifen können.

Erstellen Sie aufgabenorientierte benutzerdefinierte Agenten für Ihren Codebase, die Engineering-Aufgaben mit hoher Präzision ausführen, angetrieben durch Intelligenz und Kontext aus Ihren Daten. Erstellen Sie Agenten für Anwendungsfälle wie Systemdesign, Debugging, Integrationstests, Onboarding usw.

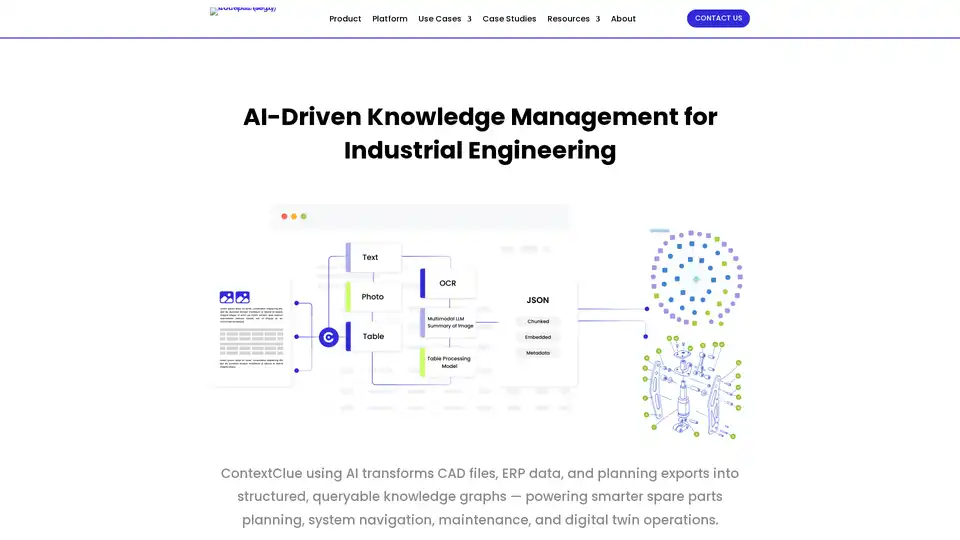

Optimieren Sie Ingenieurworkflows mit intelligentem Wissensmanagement – organisieren, durchsuchen und teilen Sie technische Daten in Ihrem gesamten Ökosystem mit den KI-gestützten Tools von ContextClue für Wissensgraphen und digitale Zwillinge.

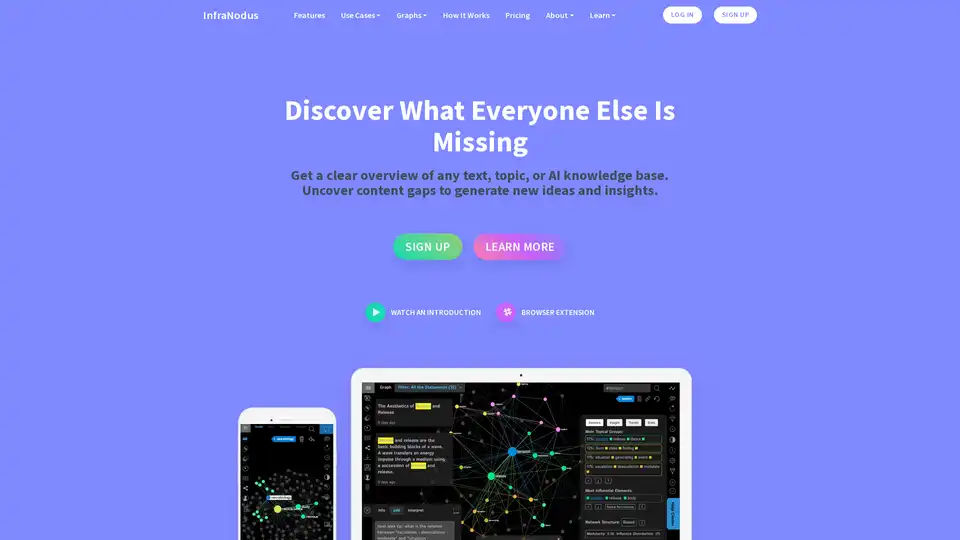

InfraNodus ist ein KI-Textanalyse-Tool, das Wissensgraphen nutzt, um Texte zu visualisieren, Inhaltslücken aufzudecken und neue Insights für Forschung, Ideation und SEO-Optimierung zu generieren.

Oda Studio bietet KI-gestützte Lösungen für komplexe Datenanalysen und wandelt unstrukturierte Daten in umsetzbare Erkenntnisse für die Bau-, Finanz- und Medienbranche um. Experten für Vision-Language AI und Knowledge Graphs.

Lettria ist eine KI-Plattform, die unstrukturierte Daten in strukturiertes Wissen umwandelt und so intelligentere Entscheidungen ermöglicht. Steigern Sie die RAG-Genauigkeit mit Lettrias graphbasierter KI.

Cognee ist eine KI-Speicher-Engine für KI-Agenten, die zuverlässigen Speicher benötigen. Es bietet modulare Speicherschichten für Branchen wie Bauwesen, Bildung und Finanzen und ermöglicht so Kontext-Engineering und genaue Antworten.

Lettria ist eine KI-Plattform, die unstrukturierte Daten mithilfe von GraphRAG in strukturiertes Wissen umwandelt und so die Entscheidungsfindung in regulierten Branchen wie Finanzen, Gesundheitswesen und Recht verbessert.

Akooda ist eine KI-gestützte Enterprise-Intelligence-Plattform, die die Daten Ihres Unternehmens sicher durchsucht, umsetzbare Einblicke liefert und Datensilos in einen zentralen Wissenshub verwandelt.

Jiff Genius AI ist eine KI-gestützte Finanzanalyseplattform, die fortschrittliche Handelswerkzeuge, Echtzeit-Marktanalyse und automatisierte Handelsfähigkeiten für Anleger aller Stufen bietet.

Discovery Outcomes ist ein KI-gestütztes GTM-Wissensgraph, das öffentliche Daten zu Unternehmen, Wettbewerbern und Märkten abbildet und schnelle, kontextbezogene Antworten für Enterprise-Sales-, Marketing- und Produktteams liefert.

Kaba ist ein Open-Source-Digital-Labor für Wissenschaft und KI, das die Erstellung persönlicher Wissensgraphen in einer sicheren, privaten Umgebung ermöglicht. Es ermöglicht Benutzern, ihre Daten und ihre Zukunft zu besitzen.

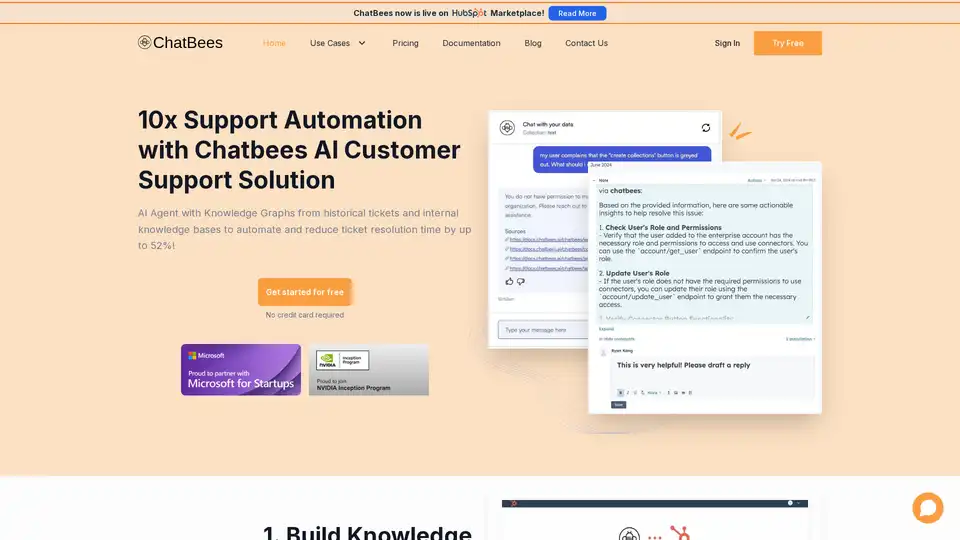

10-fache Kundensupport-Automatisierung mit ChatBees AI. Automatisieren Sie die Ticketlösung mit KI-Agenten, die Wissensgraphen verwenden, und steigern Sie die Kundenzufriedenheit. Testen Sie es kostenlos!