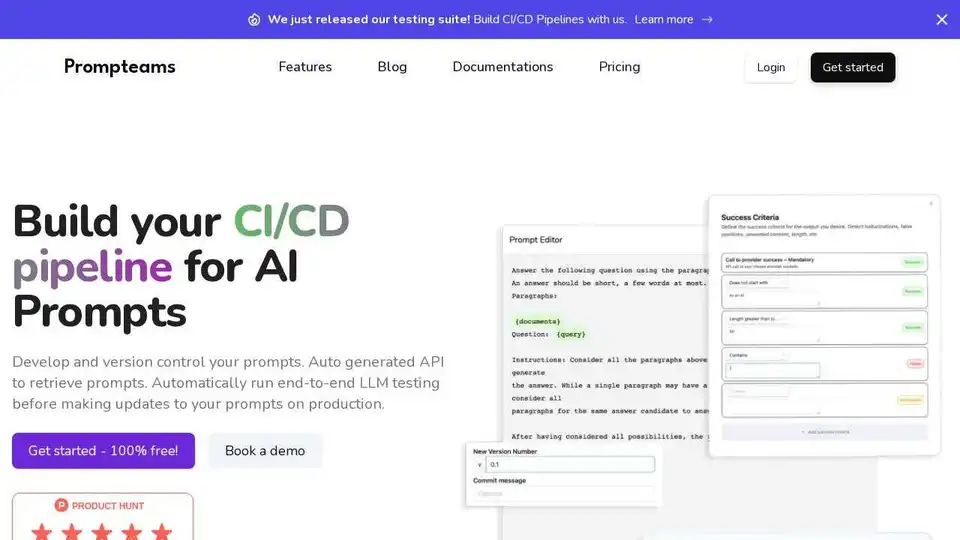

Prompteams

Übersicht von Prompteams

Prompteams: Das Git der KI-Prompts

Prompteams ist ein KI-Prompt-Management-System, das Teams bei der Entwicklung, Versionskontrolle und dem Testen ihrer KI-Prompts unterstützt. Es bietet automatisch generierte APIs für den einfachen Abruf von Prompts und ermöglicht es Benutzern, CI/CD-Pipelines für End-to-End-LLM-Tests zu erstellen, bevor sie Updates in der Produktion bereitstellen.

Was ist Prompteams?

Prompteams ist eine Plattform, die die Verwaltung von KI-Prompts vereinfacht und es Branchenspezialisten und Ingenieuren ermöglicht, effektiv zusammenzuarbeiten. Es bietet Tools zum Testen, Versionieren und Bereitstellen von Prompts und gewährleistet so eine hohe Qualität und nahtlose Integration.

Hauptmerkmale:

- Versionskontrolle: Verwenden Sie Git-ähnliche Funktionen, um Ihre Prompts zu verwalten, indem Sie Repositories und Branches erstellen, um Ihre Prompts zu iterieren.

- Unbegrenzte Testfälle: Erstellen und führen Sie unbegrenzte Testfälle aus, um die Qualität Ihrer Prompts sicherzustellen und Halluzinationen, Probleme und Grenzfälle zu überprüfen.

- Echtzeit-APIs: Aktualisieren Sie Ihre Prompts mit einem einzigen Klick über Echtzeit-APIs und stellen Sie sicher, dass jeder Branch oder Prompt aktualisiert wird, ohne dass Sie Code ändern müssen.

- CI/CD-Pipelines: Erstellen Sie CI/CD-Pipelines, um das Testen und Bereitstellen Ihrer Prompts zu automatisieren.

So verwenden Sie Prompteams:

- Erstellen Sie ein Konto und ein Team.

- Laden Sie Ihre Teammitglieder mit einem Einladungscode ein.

- Erstellen Sie Repositories und Branches für Ihre Projekte.

- Entwickeln, testen und versionieren Sie Ihre Prompts.

- Verwenden Sie die Echtzeit-APIs, um Ihre Prompts bereitzustellen.

Warum ist Prompteams wichtig?

- Verbesserte Zusammenarbeit: Erleichtert die Zusammenarbeit zwischen Branchenspezialisten und Ingenieuren.

- Erhöhte Qualität: Gewährleistet qualitativ hochwertige Prompts durch umfassende Tests.

- Vereinfachte Bereitstellung: Vereinfacht die Bereitstellung von Prompts mit Echtzeit-APIs.

Prompteams-Preise

Prompteams bietet einen kostenlosen Starter-Plan an, der unbegrenzte Testfälle, Teammitglieder, Repositories und Echtzeit-APIs umfasst. Enterprise-Pläne mit benutzerdefinierten Funktionen und Support sind ebenfalls verfügbar.

Beste Alternativwerkzeuge zu "Prompteams"

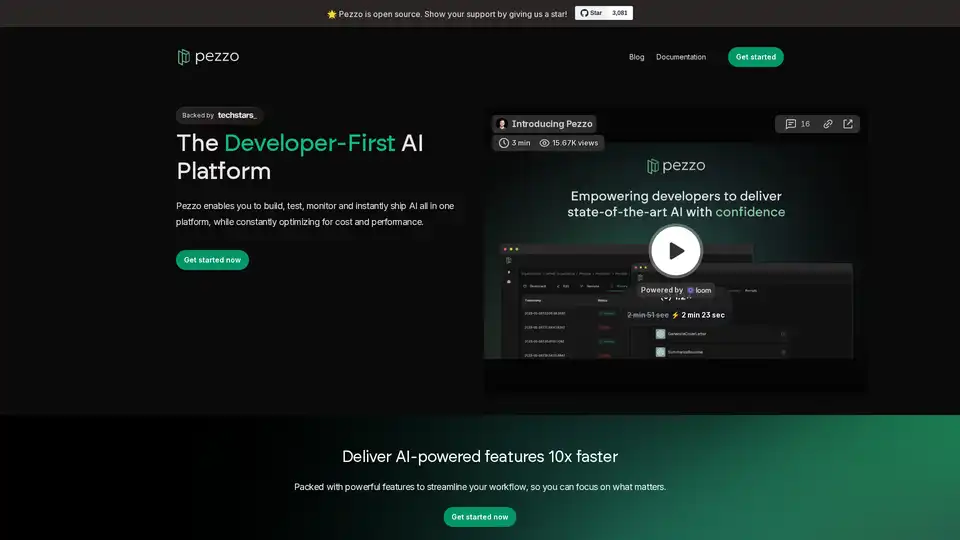

Liefern Sie wirkungsvolle KI-gestützte Software in Minuten, ohne Kompromisse bei der Qualität einzugehen. Nahtlos versenden, überwachen, testen und iterieren, ohne den Fokus zu verlieren.

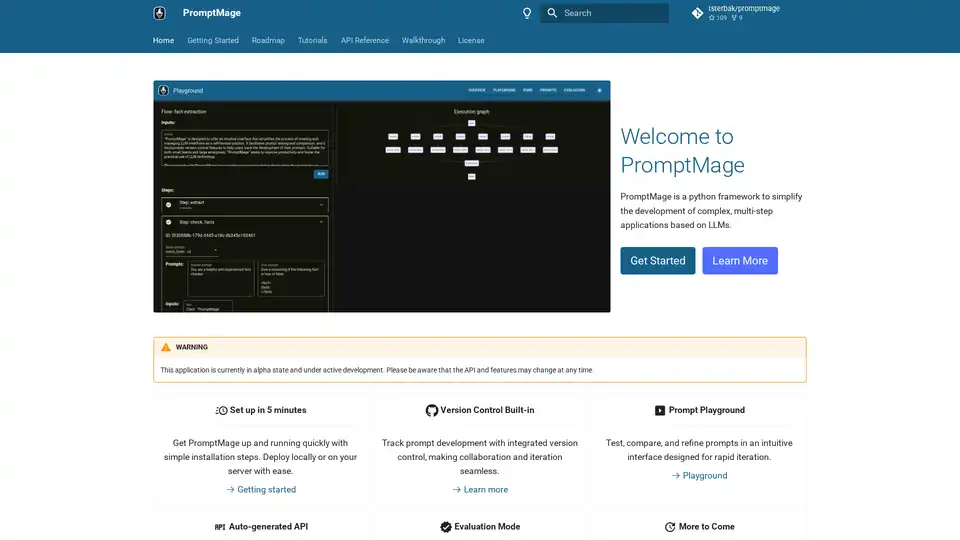

PromptMage ist ein Python-Framework, das die Entwicklung von LLM-Anwendungen vereinfacht. Es bietet Prompt-Tests, Versionskontrolle und eine automatisch generierte API für einfache Integration und Bereitstellung.

PromptLayer ist eine KI-Engineering-Plattform für Prompt-Management, -Bewertung und LLM-Observability. Arbeiten Sie mit Experten zusammen, überwachen Sie KI-Agenten und verbessern Sie die Prompt-Qualität mit leistungsstarken Tools.

APIPark ist ein Open-Source-LLM-Gateway und ein API-Entwicklerportal zur Verwaltung von LLMs in der Produktion, das Stabilität und Sicherheit gewährleistet. Optimieren Sie die LLM-Kosten und erstellen Sie Ihr eigenes API-Portal.

Dialoq AI ist eine einheitliche API-Plattform, die es Entwicklern ermöglicht, einfach auf über 200 KI-Modelle zuzugreifen und diese auszuführen, wodurch Entwicklungszeit und -kosten reduziert werden. Es bietet Funktionen wie Caching, Load Balancing und automatische Fallbacks für eine zuverlässige KI-App-Entwicklung.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

Lunary ist eine Open-Source-LLM-Engineering-Plattform, die Observability, Prompt-Management und Analysen für die Erstellung zuverlässiger KI-Anwendungen bietet. Es bietet Tools für das Debugging, die Leistungsverfolgung und die Gewährleistung der Datensicherheit.

16x Prompt ist ein KI-Codierungstool zur Verwaltung des Code-Kontexts, zur Anpassung von Prompts und zur schnelleren Bereitstellung von Funktionen mit LLM-API-Integrationen. Ideal für Entwickler, die eine effiziente KI-gestützte Codierung suchen.

Freeplay ist eine KI-Plattform, die Teams bei der Entwicklung, dem Testen und der Verbesserung von KI-Produkten durch Prompt-Management, Evaluierungen, Observability und Datenprüfungsworkflows unterstützt. Sie optimiert die KI-Entwicklung und gewährleistet eine hohe Produktqualität.

Portkey stattet KI-Teams mit einem Produktionsstapel aus: Gateway, Observability, Schutzmaßnahmen, Governance und Prompt-Management in einer Plattform.

Keywords AI ist eine führende LLM-Monitoring-Plattform, die für KI-Startups entwickelt wurde. Überwachen und verbessern Sie Ihre LLM-Anwendungen einfach mit nur 2 Codezeilen. Debuggen Sie, testen Sie Prompts, visualisieren Sie Protokolle und optimieren Sie die Leistung für zufriedene Benutzer.

Verbessern Sie APM mit OpenLIT, einer Open-Source-Plattform auf OpenTelemetry. Vereinfachen Sie die KI-Entwicklung mit einheitlichen Traces und Metriken in einer leistungsstarken Schnittstelle und optimieren Sie die Observability von LLM und GenAI.

Langtail ist eine Low-Code-Plattform zum sicheren Testen und Debuggen von KI-Anwendungen. Testen Sie LLM-Prompts mit realen Daten, fangen Sie Fehler ab und gewährleisten Sie KI-Sicherheit. Probieren Sie es kostenlos aus!

Confident AI ist eine auf DeepEval basierende LLM-Evaluierungsplattform, die Ingenieurteams befähigt, die Leistung von LLM-Anwendungen zu testen, zu bewerten, zu sichern und zu verbessern. Sie bietet erstklassige Metriken, Schutzmaßnahmen und Beobachtbarkeit zur Optimierung von KI-Systemen und zum Aufdecken von Regressionen.