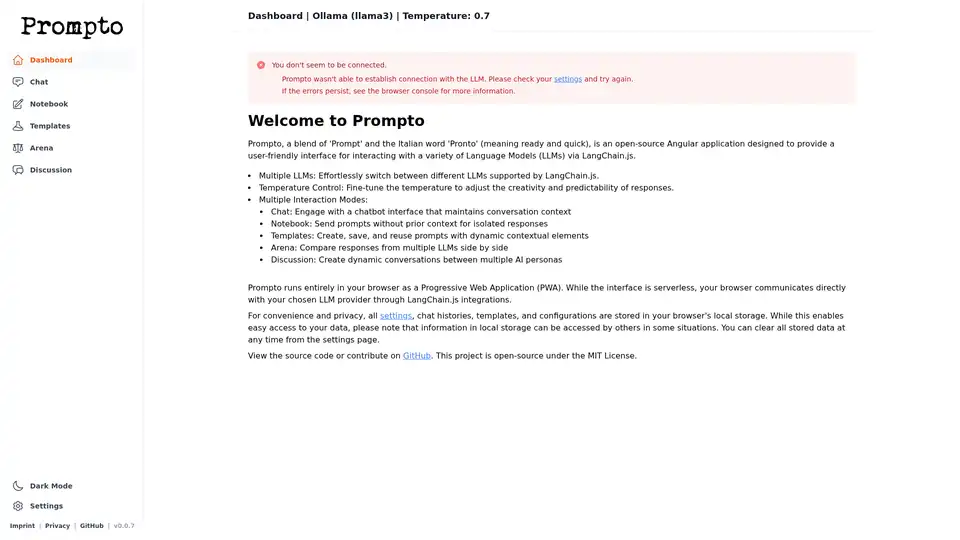

Prompto

Übersicht von Prompto

Was ist Prompto?

Prompto ist eine Open-Source-Webanwendung, die entwickelt wurde, um die Interaktion mit Sprachmodellen (LLMs) einfach und effizient zu gestalten. Der Name selbst ist eine Mischung aus 'Prompt' und dem italienischen Wort 'Pronto' (was bereit und schnell bedeutet) und unterstreicht den Fokus auf eine schnelle und einfache LLM-Interaktion. Es nutzt LangChain.js, um eine benutzerfreundliche Schnittstelle für die Interaktion mit verschiedenen LLMs bereitzustellen.

Wie funktioniert Prompto?

Prompto arbeitet als Progressive Web Application (PWA), die vollständig in Ihrem Browser ausgeführt wird. Es ist eine serverlose Schnittstelle, die über LangChain.js-Integrationen direkt mit Ihrem gewählten LLM-Anbieter kommuniziert. Hier ist eine Aufschlüsselung:

- Clientseitiger Betrieb: Die Anwendung läuft in Ihrem Browser, wodurch Datenschutz gewährleistet und serverseitige Abhängigkeiten reduziert werden.

- LangChain.js-Integration: Es verwendet LangChain.js, um sich mit verschiedenen LLMs zu verbinden und mit ihnen zu interagieren.

- Lokaler Speicher: Alle Einstellungen, Chatverläufe, Vorlagen und Konfigurationen werden zur Bequemlichkeit und für schnellen Zugriff im lokalen Speicher Ihres Browsers gespeichert. Beachten Sie jedoch, dass lokale Speicherdaten unter bestimmten Umständen von anderen abgerufen werden können. Seien Sie daher bei sensiblen Informationen vorsichtig. Sie können diese Daten auf der Einstellungsseite löschen.

Hauptmerkmale von Prompto

Prompto bietet eine Reihe von Funktionen, die Ihre Interaktionen mit LLMs optimieren sollen:

- Unterstützung mehrerer LLMs: Einfaches Umschalten zwischen verschiedenen von LangChain.js unterstützten LLMs.

- Temperaturregelung: Feinabstimmung der Temperatureinstellung, um die Kreativität und Vorhersagbarkeit von LLM-Antworten anzupassen. Eine niedrigere Temperatur führt zu vorhersehbareren und fokussierteren Antworten, während eine höhere Temperatur zu kreativeren und vielfältigeren Ergebnissen führt.

- Mehrere Interaktionsmodi:

- Chat: Beteiligen Sie sich an Konversationen mit einem Chatbot, der den Kontext über mehrere Runden hinweg beibehält. Ideal für Aufgaben, die einen fortlaufenden Dialog erfordern.

- Notebook: Senden Sie Prompts ohne vorherigen Kontext. Dieser Modus ist nützlich für isolierte Abfragen, bei denen Sie jedes Mal eine neue Antwort benötigen.

- Vorlagen: Erstellen, speichern und verwenden Sie Prompts mit dynamischen kontextbezogenen Elementen wieder. Mit dieser Funktion können Sie wiederverwendbare Prompts für konsistente Ergebnisse erstellen.

- Arena: Vergleichen Sie Antworten von mehreren LLMs nebeneinander, um das beste Modell für eine bestimmte Aufgabe auszuwählen. Diese Funktion eignet sich hervorragend zur Bewertung der Leistung verschiedener Modelle.

- Diskussion: Erstellen Sie dynamische Konversationen zwischen mehreren KI-Personas, um komplexe Interaktionen zu simulieren und verschiedene Perspektiven zu erkunden. Dies ist eine innovative Möglichkeit, die Fähigkeiten von LLMs zu erkunden.

Wie man Prompto benutzt

- Zugriff auf Prompto: Da es sich um eine PWA handelt, können Sie über Ihren Webbrowser darauf zugreifen.

- LLM-Einstellungen konfigurieren: Konfigurieren Sie Prompto, um sich über LangChain.js mit Ihrem bevorzugten LLM-Anbieter zu verbinden.

- Interaktionsmodus auswählen: Wählen Sie je nach Bedarf zwischen Chat, Notebook, Vorlagen, Arena oder Diskussion.

- Mit Prompts beginnen: Geben Sie Ihre Prompts ein und interagieren Sie mit dem LLM.

- Einstellungen verwalten: Passen Sie die Anwendungseinstellungen an, einschließlich Temperatur und Datenspeichereinstellungen.

Warum Prompto wählen?

Prompto vereinfacht die Interaktion mit LLMs und macht sie einem breiteren Publikum zugänglich. Hier sind die Gründe, warum es ein wertvolles Werkzeug ist:

- Benutzerfreundliche Oberfläche: Prompto bietet eine saubere und intuitive Oberfläche, die auch für Benutzer ohne umfassende technische Kenntnisse einfach zu bedienen ist.

- Vielseitige Funktionalität: Mit Unterstützung für mehrere LLMs, Temperaturregelung und verschiedenen Interaktionsmodi deckt Prompto ein breites Spektrum an Anwendungsfällen ab.

- Datenschutzorientiert: Da Prompto vollständig im Browser ausgeführt wird und Daten lokal speichert, priorisiert es den Datenschutz der Benutzer.

- Open-Source: Als Open-Source-Projekt profitiert Prompto von Community-Beiträgen und kontinuierlicher Verbesserung.

Für wen ist Prompto geeignet?

Prompto ist ein wertvolles Werkzeug für:

- Entwickler: Experimentieren mit verschiedenen LLMs und Prompt-Engineering-Techniken.

- Forscher: Vergleichen der Leistung verschiedener LLMs.

- Content Creators: Generieren kreativer Inhalte und Erkunden KI-gesteuerter Zusammenarbeit.

- Jeder, der daran interessiert ist, die Fähigkeiten von LLMs in einer benutzerfreundlichen Umgebung zu erkunden.

Erste Schritte

Um Prompto zu verwenden, besuchen Sie einfach die Webanwendung und befolgen Sie die Einrichtungsanweisungen. Sie können auch zum Projekt beitragen oder den Quellcode auf GitHub anzeigen. Das Projekt ist Open-Source unter der MIT-Lizenz und lädt zu Community-Beiträgen und Weiterentwicklung ein.

Hinweis zum lokalen Speicher

Obwohl der lokale Speicher Komfort bietet, sollten Sie sich der Sicherheitsrisiken bewusst sein. Daten, die im lokalen Speicher gespeichert sind, können in einigen Situationen von anderen abgerufen werden. Für sensible Informationen sollten Sie sicherere Speichermethoden verwenden.

Beste Alternativwerkzeuge zu "Prompto"

BenchLLM ist der beste Weg, LLM-gestützte Apps zu bewerten. Es hilft Ihnen, Testsuiten für Ihre Modelle zu erstellen und Qualitätsberichte mit automatisierten, interaktiven oder benutzerdefinierten Bewertungsstrategien zu erstellen.

Skymel ADK bietet eine vereinfachte Möglichkeit, intelligente, selbstheilende KI-Agenten zu erstellen. Es verfügt über eine Multi-Modell-Gehirnarchitektur, dynamische Workflow-Generierung und erfordert keinen Orchestrierungs-Code, was eine schnelle Bereitstellung und kontinuierliches Lernen ermöglicht.

Zep ist eine Context-Engineering-Plattform zum Erstellen personalisierter KI-Agenten. Sie verfügt über Agentenspeicher, Graph RAG und automatisierte Kontextzusammenstellung, sodass sich Agenten wichtige Details merken und auf relevante Daten zugreifen können.

Parea AI ist eine KI-Experimentier- und Annotationsplattform, die Teams dabei unterstützt, LLM-Anwendungen zuverlässig auszuliefern. Sie bietet Funktionen für die Experimentverfolgung, Observability, Human Review und Prompt-Bereitstellung.

Parea AI ist die ultimative Experimentier- und Human-Annotationsplattform für AI-Teams, die nahtlose LLM-Bewertung, Prompt-Tests und Produktionsbereitstellung für zuverlässige AI-Anwendungen ermöglicht.

Smolagents ist eine minimalistische Python-Bibliothek zum Erstellen von KI-Agenten, die durch Code reasoning und handeln. Sie unterstützt LLM-agnostische Modelle, sichere Sandboxes und nahtlose Hugging Face Hub-Integration für effiziente, codebasierte Agent-Workflows.

TemplateAI ist die führende NextJS-Vorlage für AI-Apps mit Supabase-Authentifizierung, Stripe-Zahlungen, OpenAI/Claude-Integration und einsatzbereiten AI-Komponenten für schnelle Full-Stack-Entwicklung.

Rierino ist eine leistungsstarke Low-Code-Plattform, die E-Commerce und digitale Transformation mit KI-Agenten, composable Commerce und nahtlosen Integrationen für skalierbare Innovation beschleunigt.

Openlayer ist eine KI-Unternehmensplattform, die eine einheitliche KI-Bewertung, Observability und Governance für KI-Systeme von ML bis LLMs bietet. Testen, überwachen und verwalten Sie KI-Systeme während des gesamten KI-Lebenszyklus.

Tavily ist eine Echtzeit-Suchmaschine für KI-Agenten und RAG-Workflows und bietet schnelle und sichere APIs für die Websuche und Content-Extraktion. Von über 700.000 Entwicklern genutzt.

Trainkore: Eine Prompting- und RAG-Plattform zur Automatisierung von Prompts, Modellwechsel und Evaluierung. Sparen Sie 85 % der LLM-Kosten.

Agents-Flex ist ein einfaches und leichtgewichtiges LLM-Anwendungsentwicklungs-Framework, das in Java entwickelt wurde und LangChain ähnelt.

LangSearch bietet eine Web Search API und eine Semantic Rerank API, um LLM-Anwendungen mit sauberem, genauem Kontext zu verbinden.

Composio: APIs, SDKs, Integrationen für KI-Agenten zur Interaktion mit Apps wie Slack, HubSpot, GitHub. Erstellen Sie Agenten, die mehr können.