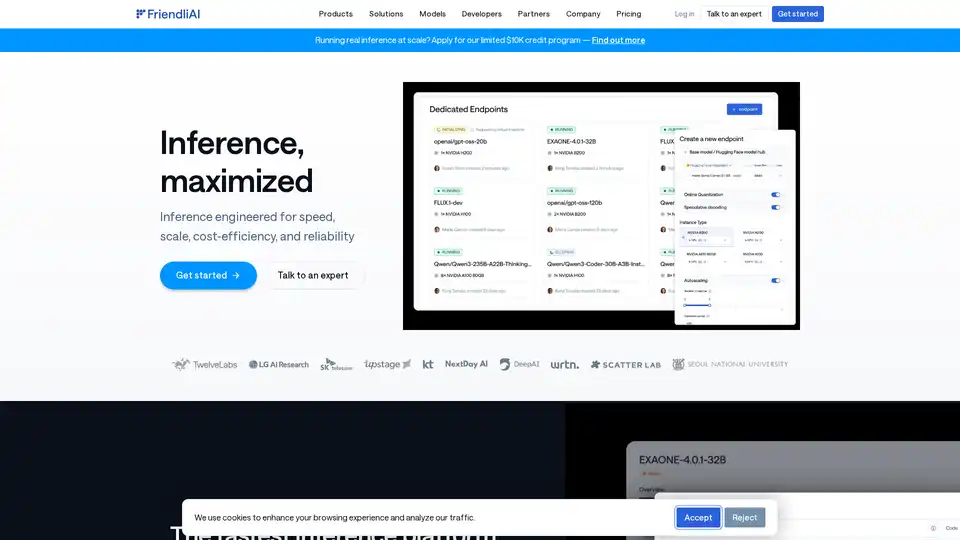

FriendliAI の概要

FriendliAI: ジェネレーティブAIインフラストラクチャ企業

FriendliAIは、ジェネレーティブAIインフラストラクチャを専門とする企業であり、AI推論における速度、規模、コスト効率、および信頼性のために設計されたプラットフォームを提供しています。AIモデルのパフォーマンスを最大化し、大規模なAI導入を目指す企業にソリューションを提供することを目指しています。

FriendliAIとは?

FriendliAIは、高速かつ信頼性の高いAIモデルのデプロイメントを提供するように設計された推論プラットフォームです。モデルレベルのブレークスルーとインフラストラクチャレベルの最適化を組み合わせることで、2倍以上の高速な推論を実現する専用スタックを提供することで際立っています。

FriendliAIの仕組み

FriendliAIは、いくつかの主要な機能を通じて高いパフォーマンスを実現しています。

- カスタムGPUカーネル: GPU上でのAIモデルの実行を最適化します。

- スマートキャッシュ: 頻繁に使用されるデータを効率的に保存および取得します。

- 継続的なバッチ処理: 複数のリクエストをグループ化してスループットを向上させます。

- 投機的デコード: 次のトークンを予測することにより、テキスト生成を高速化します。

- 並列推論: ワークロードを複数のGPUに分散します。

- 高度なキャッシュ: より高速なデータアクセスを実現するために、キャッシュメカニズムをさらに強化します。

- マルチクラウドスケーリング: 柔軟性と冗長性を実現するために、さまざまなクラウドプロバイダーにまたがるスケーリングを可能にします。

主な機能と利点

- 高速性: レイテンシを削減して、競争上の優位性を提供します。

- 保証された信頼性: 地理的に分散されたインフラストラクチャを備えた99.99%のアップタイムSLAを提供します。

- コスト効率: GPUの使用率を最適化することで、大幅なコスト削減を実現します。

- スケーラビリティ: 豊富なGPUリソース全体でシームレスにスケーリングします。

- 使いやすさ: 459,400以上のHugging Faceモデルのワンクリックデプロイメントをサポートします。

- カスタムモデルのサポート: ユーザーは、独自に微調整されたモデルまたはプロプライエタリモデルを持ち込むことができます。

FriendliAIを選ぶ理由

- 比類のないスループット: 大量のデータを処理するための高いスループットを提供します。

- 超低レイテンシ: リアルタイムアプリケーション向けの迅速な応答時間を保証します。

- グローバルな可用性: グローバル地域全体で信頼性の高いパフォーマンスを提供します。

- エンタープライズグレードの耐障害性: トラフィックの急増時でも、AIがオンラインで応答性を維持できるようにします。

- 組み込みの監視とコンプライアンス: 監視ツールとコンプライアンス対応アーキテクチャを提供します。

FriendliAIは誰のためですか?

FriendliAIは、以下のような企業に適しています。

- AIアプリケーションをスケールアップする企業。

- AIモデルをデプロイする開発者。

- 費用対効果の高いAI推論を求める組織。

- 信頼性の高いAIパフォーマンスを必要とする企業。

FriendliAIの使用方法

FriendliAIを使い始めるには:

- サインアップ: FriendliAIプラットフォームでアカウントを作成します。

- モデルのデプロイ: 459,400以上のHugging Faceモデルから選択するか、独自のモデルを持ち込みます。

- 設定の構成: スケーリングとパフォーマンスの設定を調整します。

- パフォーマンスの監視: 組み込みの監視ツールを使用して、アップタイムとレイテンシを追跡します。

実用的な価値とユースケース

FriendliAIは、言語からオーディオ、ビジョンまで、さまざまなモデルをサポートしています。リストされているモデルの例は次のとおりです。

- Llama-3.2-11B-Vision (Meta)

- whisper-small-wolof (M9and2M)

- Qwen2.5-VL-7B-Instruct-Android-Control (OfficerChul)

- さまざまなモダリティにわたるさらに多くのモデル

これらのモデルは、さまざまなタイプのAIタスクを処理する上でのFriendliAIプラットフォームの多様な適用性を強調しています。

堅牢な信頼性とコスト削減

ユーザーは、次のような大きなメリットを報告しています。

- カスタムモデルAPIは、組み込みの監視機能を備えて約1日で起動されました。

- トークン処理は、50%少ないGPUを使用して数兆にスケールされました。

- 変動するトラフィックは、自動スケーリングのおかげで懸念なく処理されます。

結論

FriendliAIは、速度、信頼性、およびコスト効率に焦点を当てたAI推論のための包括的なソリューションを提供します。そのプラットフォームは、幅広いモデルをサポートし、AIを大規模にデプロイするために必要なツールを提供し、AIテクノロジーを効果的に活用しようとする企業にとって貴重なリソースとなっています。

"FriendliAI" のベストな代替ツール

Vivgrid は、開発者が安全ガードレールと低遅延推論を備えた AI エージェントを構築、監視、評価、デプロイするのに役立つ AI エージェントインフラストラクチャプラットフォームです。GPT-5、Gemini 2.5 Pro、DeepSeek-V3 をサポートしています。

Nebius は、AI インフラストラクチャを民主化するために設計された AI クラウド プラットフォームであり、柔軟なアーキテクチャ、テスト済みのパフォーマンス、およびトレーニングと推論のために NVIDIA GPU と最適化されたクラスターによる長期的な価値を提供します。

Float16.cloudは、AI開発用のサーバーレスGPUを提供します。 従量制料金でH100 GPUにモデルを即座にデプロイできます。 LLM、微調整、トレーニングに最適。

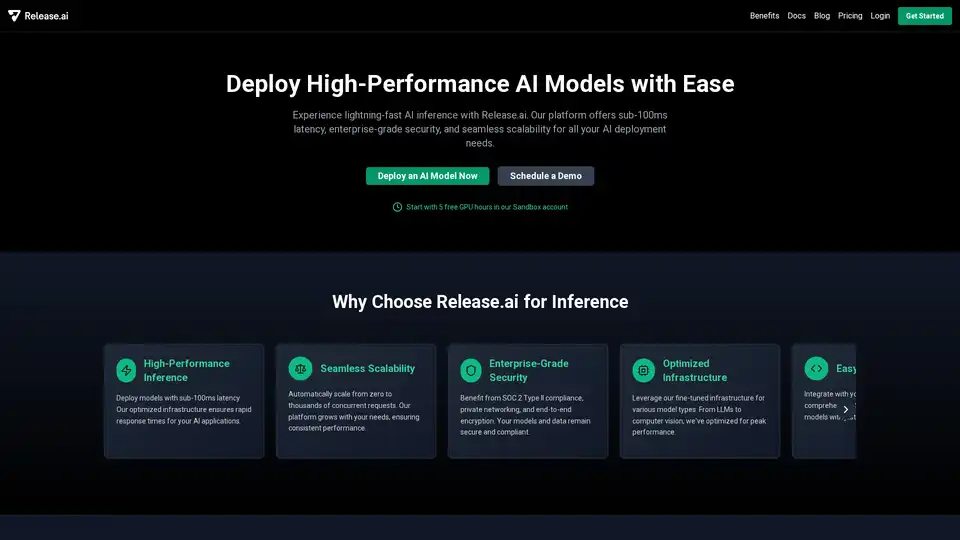

Release.ai は、100 ミリ秒未満のレイテンシ、エンタープライズグレードのセキュリティ、シームレスなスケーラビリティにより、AI モデルのデプロイを簡素化します。本番環境に対応した AI モデルを数分でデプロイします。

Runpodは、AIモデルの構築とデプロイメントを簡素化するAIクラウドプラットフォームです。 AI開発者向けに、オンデマンドGPUリソース、サーバーレススケーリング、およびエンタープライズグレードの稼働時間を提供します。

GPUXは、StableDiffusionXL、ESRGAN、AlpacaLLMなどのAIモデル向けに1秒のコールドスタートを実現するサーバーレスGPU推論プラットフォームで、最適化されたパフォーマンスとP2P機能を備えています。

開発者向けの超高速AIプラットフォーム。シンプルなAPIで200以上の最適化されたLLMとマルチモーダルモデルをデプロイ、ファインチューニング、実行 - SiliconFlow。

Xanderは、オープンソースのデスクトッププラットフォームで、ノーコードAIモデルトレーニングを可能にします。自然言語でタスクを記述するだけで、テキスト分類、画像分析、LLMファインチューニングの自動化パイプラインを実行し、ローカルマシンでプライバシーとパフォーマンスを確保します。

DeepSeek V3を無料でオンラインでお試しください。登録不要。この強力なオープンソースAIモデルは671Bパラメータを備え、商用利用をサポートし、ブラウザデモまたはGitHubでのローカルインストールで無制限アクセスを提供します。

Runpodは、AIモデルの構築とデプロイメントを簡素化するオールインワンAIクラウドプラットフォームです。強力なコンピューティングと自動スケーリングにより、AIを簡単にトレーニング、微調整、デプロイできます。

Vast.aiで高性能GPUを低コストでレンタル。 AI、機械学習、深層学習、レンダリング用のGPUレンタルを即座に展開。 柔軟な価格設定と迅速なセットアップ。

Lightning AIは、AIエージェント、データ、AIアプリを構築、展開、トレーニングするために設計されたオールインワンのクラウドワークスペースです。モデルAPI、GPUトレーニング、マルチクラウド展開を1つのサブスクリプションで入手できます。

Anyscaleは、Rayを搭載し、あらゆるクラウドまたはオンプレミスですべてのMLおよびAIワークロードを実行および拡張するためのプラットフォームです。AIアプリケーションを簡単かつ効率的に構築、デバッグ、およびデプロイします。