Thunder Compute の概要

Thunder Compute: 手頃な価格でアクセス可能なGPUクラウドプラットフォーム

Thunder Computeとは?

Thunder Computeは、AIおよび機械学習プロジェクトに取り組む研究者、スタートアップ、データサイエンティスト向けに設計されたGPUクラウドプラットフォームです。AWSなどの競合他社よりも80%安価であると主張する、ワンクリックGPUインスタンスを提供します。これにより、要求の厳しいAI/MLタスクに必要なコンピューティングパワーへのアクセスがより簡単かつ費用対効果が高くなります。

Thunder Computeの仕組み

Thunder Computeは、GPUインスタンスのセットアップと管理のプロセスを簡素化します。ユーザーは数秒で専用GPUをスピンアップし、人気のあるコードエディターであるVS Code内で直接開発できます。主な機能は次のとおりです。

- ワンクリックセットアップ: 複雑な構成なしでGPUインスタンスをすばやく起動します。

- VS Code統合: 使い慣れたVS Code環境から直接開発およびデプロイします。

- ハードウェアの柔軟性: プロジェクトのニーズに合わせてハードウェア構成を簡単に交換できます。

- 永続的な環境: 一貫した開発環境を維持します。

主な機能と利点

- コスト削減: このプラットフォームは、AWSよりも大幅に低いオンデマンド価格を提供し、開発者は資金を使い果たすことなくA100などの強力なGPUで開発できます。

- 簡素化されたセットアップ: Thunder Computeは、従来のGPUセットアップの複雑さを解消し、SSHキー、CUDAインストール、および手動の依存関係管理の必要性を排除します。

- 迅速な開発: VS Code拡張機能とインスタンステンプレートにより、開発プロセスが合理化され、ユーザーは数日ではなく数秒でプロジェクトを実行できます。

- スケーラビリティ: 数回クリックするだけでインスタンス仕様(vCPU、RAM、ストレージ)を簡単に変更して、変化するプロジェクト要件に適応できます。

- インスタンステンプレート: OllamaやComfy-uiなどの一般的なツールで使用できる事前構成済みのテンプレートにより、ユーザーは好みのフレームワークをすぐに使い始めることができます。

Thunder Computeは誰のためのものですか?

Thunder Computeは以下に最適です。

- 研究者: AI/ML研究プロジェクト向けの手頃な価格のGPUリソースにアクセスします。

- スタートアップ: インフラストラクチャコストを削減し、AI駆動型アプリケーションの開発を加速します。

- データサイエンティスト: 機械学習モデルをすばやくプロトタイプ化およびスケーリングします。

- 機械学習エンジニア: 開発とデプロイのプロセスを合理化します。

Thunder Computeが重要な理由

Thunder ComputeはGPUコンピューティングへのアクセスを民主化し、より幅広いユーザーにとって手頃な価格でアクセスしやすくします。GPUインスタンスのセットアップと管理を簡素化することにより、Thunder Computeは、コストや複雑さに制約されることなく、革新的なAI/MLアプリケーションの構築に集中できるように開発者を支援します。

お客様の声

- 「VS Code拡張機能は、より速く反復するのに役立ちます。論文の締め切りをストレスの少ないものにするものはすべて勝利です。」- 機械学習博士、U.C. Berkeley

- 「私はより速く出荷し、CEOは節約を愛しています。これまでのところ、私は9人のMLEに切り替えるよう説得しました。」- MLエンジニア、シリーズBスタートアップ

- 「価値の量は非常識です。私たちはブートストラップされており、24時間体制で2〜3のファインチューニングジョブを実行しています。」- データサイエンスコンサルタントの共同創設者

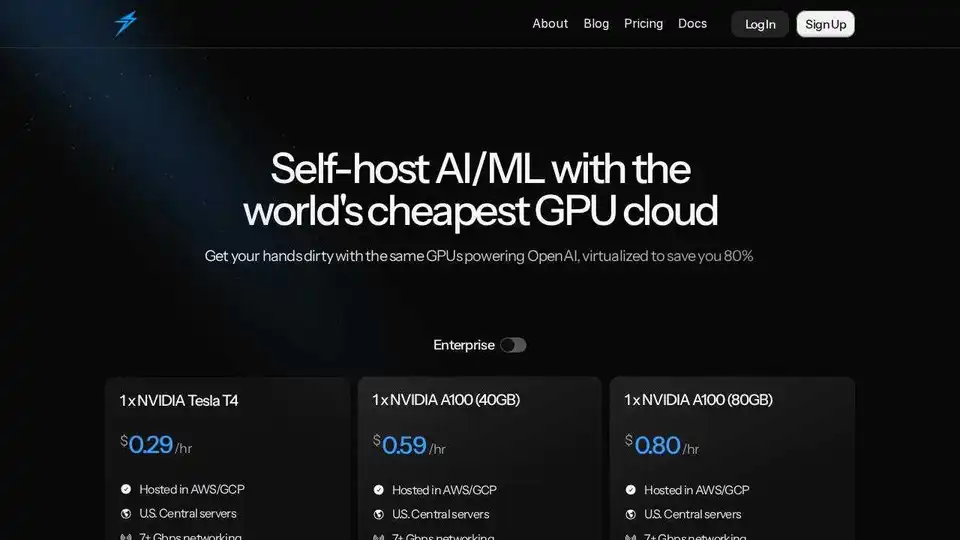

価格設定

Thunder Computeは、以下を含むさまざまなGPU構成に対して、競争力のあるオンデマンド価格を提供しています。

- Tesla T4

- A100 40GB

- A100 80GB

ユーザーは、特定のニーズに合わせてvCPU、RAM、ストレージをカスタマイズできます。ベータ期間中、Thunder Computeは最初のクレジット購入の100%を最大50ドルまでマッチングします。

結論として、Thunder Computeは、AI/ML開発のための手頃な価格でアクセス可能なGPUコンピューティングを求めるすべての人に、魅力的なソリューションを提供します。ワンクリックセットアップ、VS Code統合、および競争力のある価格設定により、研究者、スタートアップ、およびデータサイエンティストにとって貴重なツールとなります。

"Thunder Compute" のベストな代替ツール

Anyscaleは、Rayを搭載し、あらゆるクラウドまたはオンプレミスですべてのMLおよびAIワークロードを実行および拡張するためのプラットフォームです。AIアプリケーションを簡単かつ効率的に構築、デバッグ、およびデプロイします。

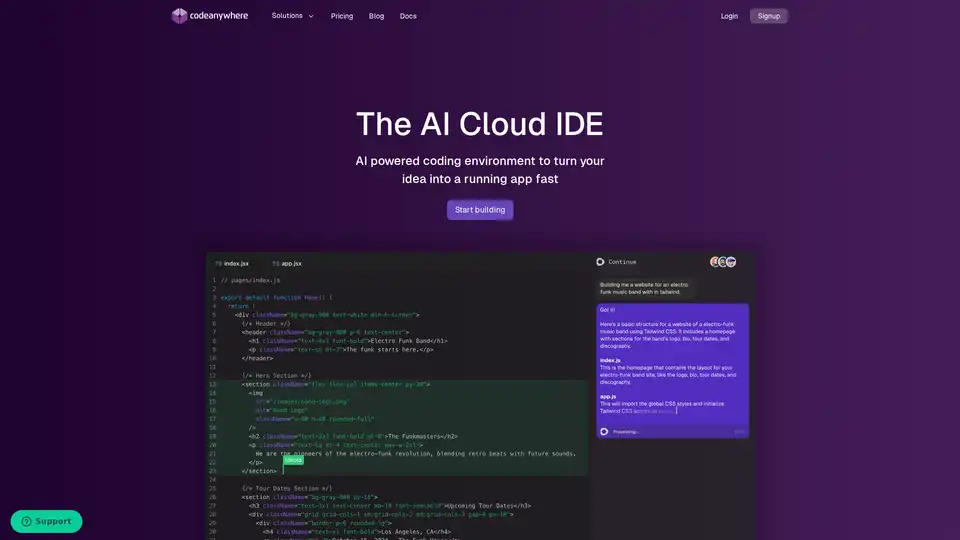

Codeanywhereは、ブラウザでVS Codeのような体験を提供するAI搭載クラウドIDEです。複数の言語、AIコーディングアシスタンス、簡単なコラボレーションをサポートし、迅速かつ効率的なAIアプリケーション開発向けに設計されています。

Novita AIは200以上のモデルAPI、カスタムデプロイ、GPUインスタンス、サーバーレスGPUを提供。AIを拡張し、パフォーマンスを最適化し、簡単に効率的に革新します。

GreenNodeは、包括的なAI対応インフラストラクチャと、H100 GPUを搭載したクラウドソリューションを、1時間あたり2.34ドルから提供します。 事前構成されたインスタンスとフルスタックAIプラットフォームにアクセスして、AIジャーニーを開始してください。

SaladCloudは、AI/ML推論向けの低価格で安全なコミュニティ主導の分散型GPUクラウドを提供します。計算コストを最大90%削減。AI推論、バッチ処理などに最適です。

Vast.aiで高性能GPUを低コストでレンタル。 AI、機械学習、深層学習、レンダリング用のGPUレンタルを即座に展開。 柔軟な価格設定と迅速なセットアップ。

ChatLLaMA は LLaMA モデルに基づく LoRA 訓練 AI アシスタントで、ローカル GPU でカスタム個人会話が可能。デスクトップ GUI を備え、Anthropic の HH データセットで訓練、7B、13B、30B モデル対応。

Massed Compute は、AI、機械学習、データ分析向けのオンデマンド GPU および CPU クラウドコンピューティングインフラストラクチャを提供します。柔軟で手頃な価格のプランで、高性能 NVIDIA GPU にアクセスできます。

Lightning AIは、AIエージェント、データ、AIアプリを構築、展開、トレーニングするために設計されたオールインワンのクラウドワークスペースです。モデルAPI、GPUトレーニング、マルチクラウド展開を1つのサブスクリプションで入手できます。

dstackは、オープンソースのAIコンテナオーケストレーションエンジンであり、MLチームにクラウド、Kubernetes、およびオンプレミス全体でのGPUプロビジョニングとオーケストレーションのための統合されたコントロールプレーンを提供します。開発、トレーニング、および推論を効率化します。

Deep Infra は、低コストでスケーラブルな AI 推論プラットフォームで、DeepSeek-V3.2、Qwen、OCR ツールなどの 100 以上の ML モデルをサポート。開発者向け API、GPU レンタル、データゼロ保持。

Metaflowは、Netflixによる、現実のML、AI、およびデータサイエンスプロジェクトを構築および管理するためのオープンソースフレームワークです。ワークフローを拡張し、実験を追跡し、本番環境に簡単にデプロイできます。

eeat は、GPT-3.5 と GPT-4 で駆動される AI 分析ツールで、商業キーワードと競合他社の詳細データを収集し、EEAT 基準に準拠した専門コンテンツを作成して、検索エンジンのランキングとビジネスの競争力を向上させます。