Fluidstack の概要

Fluidstack:最先端のAIインフラストラクチャ

Fluidstackは、数千のGPUにまたがって最先端モデルを安全にトレーニングおよび提供するために設計された、最先端のAIクラウドプラットフォームを提供します。セットアップが不要、データエグレス料金が不要、そして24時間年中無休で対応する熟練エンジニアのサポートにより、FluidstackはAI業界で最も要求の厳しいチームから信頼されています。

Fluidstackとは? Fluidstackは、大規模なGPUリソースへの即時アクセスを提供し、チームがAIの開発とデプロイのタイムラインを加速できるようにします。これは、規模、速度、およびシンプルさのために最適化されたプラットフォームであり、野心的なAIプロジェクトに必要なインフラストラクチャを提供します。

Fluidstackの仕組みは? Fluidstackのインフラストラクチャは、AI専用に構築されており、次の機能を備えています。

- Atlas OS: AIインフラストラクチャの迅速なプロビジョニングとスムーズなオーケストレーションのために最適化されたベアメタルOS。

- Lighthouse: 信頼性の高いパフォーマンスを確保するために、問題をプロアクティブに特定して解決する監視および最適化システム。

- GPUクラスター: 完全に分離され、完全に管理され、常に利用可能な専用の高性能GPUクラスター。

主な機能と利点:

- GPUへの迅速なアクセス: H200、B200、GB200などの最新のGPUアーキテクチャにアクセスし、単一のファブリック上で12,000以上のGPUにスケールできます。

- 高性能: クラスターは、スループットを最大化するために、理論上のパフォーマンスの95%を達成するようにベンチマークされています。

- 信頼性の高い稼働時間: Lighthouseはワークロードを自動的に復旧し、エンジニアは15分以内の応答時間で待機し、ダウンタイムを最小限に抑えます。

- シングルテナントセキュリティ: インフラストラクチャは、ハードウェア、ネットワーク、およびストレージレベルで完全に分離されており、強化されたセキュリティを提供します。

- 安全な運用: Fluidstackのエンジニアは、安全なアクセス制御と監査ログを使用して、クラスターを直接保守および監視します。

ユースケース:

- 研究室: 専用のGPUクラスターを数日で起動して、研究を加速します。

- ソブリンAIイニシアチブ: 完全に物理的および運用上のセキュリティを備えたAIソリューションを即座に展開します。

- エンタープライズAIチーム: 95%以上の稼働時間、パフォーマンス、およびコンプライアンスを備えたクラスターを実行します。

- 金融サービス: 推論、モデリング、およびリスクワークロードを高速で実行します。

Fluidstackを支えるテクノロジー

Fluidstackは、堅牢で効率的なAIクラウドプラットフォームを提供するために、主要な技術コンポーネントを活用しています。

- Atlas OS: このベアメタルOSは、AIワークロード向けに微調整されており、迅速なプロビジョニングとリソースのスムーズな管理を可能にします。インフラストラクチャに対する完全な所有権と制御を提供します。

- Lighthouse: このシステムは、ワークロードを継続的に監視、修復、および最適化します。潜在的な問題をプロアクティブに対処することで、Lighthouseは信頼性の高いパフォーマンスを保証し、稼働時間を最大化します。

Fluidstackが重要な理由? Fluidstackは、アクセス可能で高性能なAIインフラストラクチャに対する重要なニーズに対応します。インフラストラクチャの遅延を解消し、安全でスケーラブルなソリューションを提供することで、Fluidstackはチームがイノベーションに集中し、AIイニシアチブを加速できるようにします。

どこでFluidstackを使用できますか? Fluidstackは、次の用途に最適です。

- 基盤モデルのトレーニング。

- 大規模な推論の実行。

- AIの研究開発の支援。

- エンタープライズAIアプリケーションのサポート。

Fluidstackを始めるには?

Fluidstackに連絡して、AIインフラストラクチャのニーズについて話し合い、より大規模に起動してより迅速に行動する方法についてご相談ください。

Fluidstackは、AIイニシアチブを効果的に拡大するために必要な制御、信頼、およびパフォーマンスを提供します。そのシングルテナントアーキテクチャ、安全な運用、および人的サポートにより、チームはインフラストラクチャの制限に妨げられることなく、最先端のAIソリューションの構築に集中できます。

"Fluidstack" のベストな代替ツール

Denvr Dataworks は、オンデマンドGPUクラウド、AI推論、プライベートAIプラットフォームを含む、高性能AIコンピューティングサービスを提供します。 NVIDIA H100、A100、Intel Gaudi HPUでAI開発を加速。

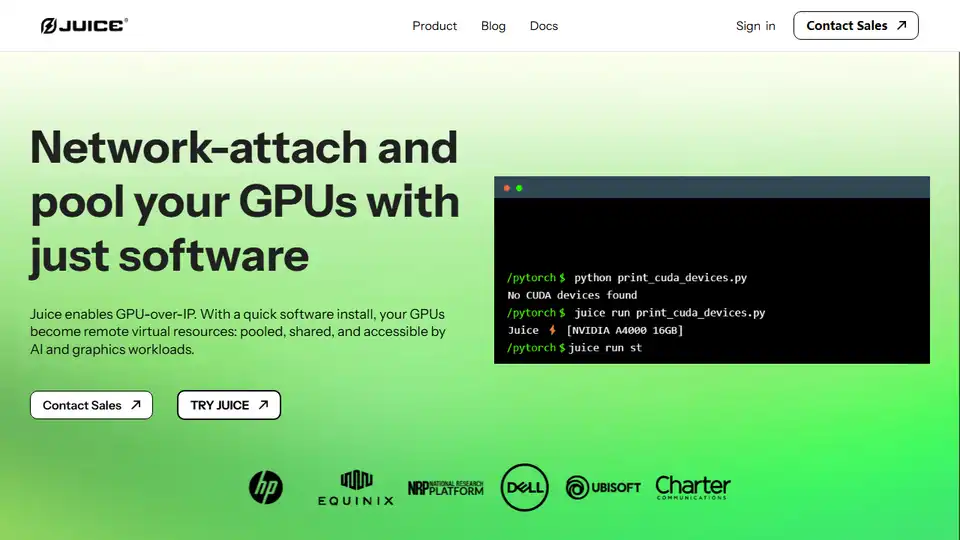

JuiceはGPU over IPを可能にし、ソフトウェアを使用してGPUをネットワーク接続してプールし、AIおよびグラフィックスのワークロードに使用できるようにします。

Vast.aiで高性能GPUを低コストでレンタル。 AI、機械学習、深層学習、レンダリング用のGPUレンタルを即座に展開。 柔軟な価格設定と迅速なセットアップ。

GreenNodeは、包括的なAI対応インフラストラクチャと、H100 GPUを搭載したクラウドソリューションを、1時間あたり2.34ドルから提供します。 事前構成されたインスタンスとフルスタックAIプラットフォームにアクセスして、AIジャーニーを開始してください。

Nebius は、AI インフラストラクチャを民主化するために設計された AI クラウド プラットフォームであり、柔軟なアーキテクチャ、テスト済みのパフォーマンス、およびトレーニングと推論のために NVIDIA GPU と最適化されたクラスターによる長期的な価値を提供します。

Massed Compute は、AI、機械学習、データ分析向けのオンデマンド GPU および CPU クラウドコンピューティングインフラストラクチャを提供します。柔軟で手頃な価格のプランで、高性能 NVIDIA GPU にアクセスできます。

Runpodは、AIモデルの構築とデプロイメントを簡素化するオールインワンAIクラウドプラットフォームです。強力なコンピューティングと自動スケーリングにより、AIを簡単にトレーニング、微調整、デプロイできます。

Runpodは、AIモデルの構築とデプロイメントを簡素化するAIクラウドプラットフォームです。 AI開発者向けに、オンデマンドGPUリソース、サーバーレススケーリング、およびエンタープライズグレードの稼働時間を提供します。

Cirrascale AI Innovation Cloudは、AI開発、トレーニング、推論のワークロードを加速します。 高スループットと低遅延で、主要なAIアクセラレータでテストおよびデプロイします。

Luminoは、グローバルクラウドプラットフォームでのAIトレーニング用の使いやすいSDKです。 MLトレーニングコストを最大80%削減し、他では利用できないGPUにアクセスします。 今すぐAIモデルのトレーニングを開始してください!

Modal: AIおよびデータチーム向けのサーバーレスプラットフォーム。独自のコードを使用して、CPU、GPU、およびデータ集約型コンピューティングを大規模に実行します。

QSC Cloudは、AI、深層学習、HPCワークロード向けに、グローバルなGPU接続を備えたトップクラスのNVIDIA GPUクラウドクラスターを提供します。

Cerebriumは、低遅延、ゼロDevOps、秒単位課金でリアルタイムAIアプリケーションのデプロイメントを簡素化するサーバーレスAIインフラストラクチャプラットフォームです。LLMとビジョンモデルをグローバルにデプロイします。

Anyscaleは、Rayを搭載し、あらゆるクラウドまたはオンプレミスですべてのMLおよびAIワークロードを実行および拡張するためのプラットフォームです。AIアプリケーションを簡単かつ効率的に構築、デバッグ、およびデプロイします。